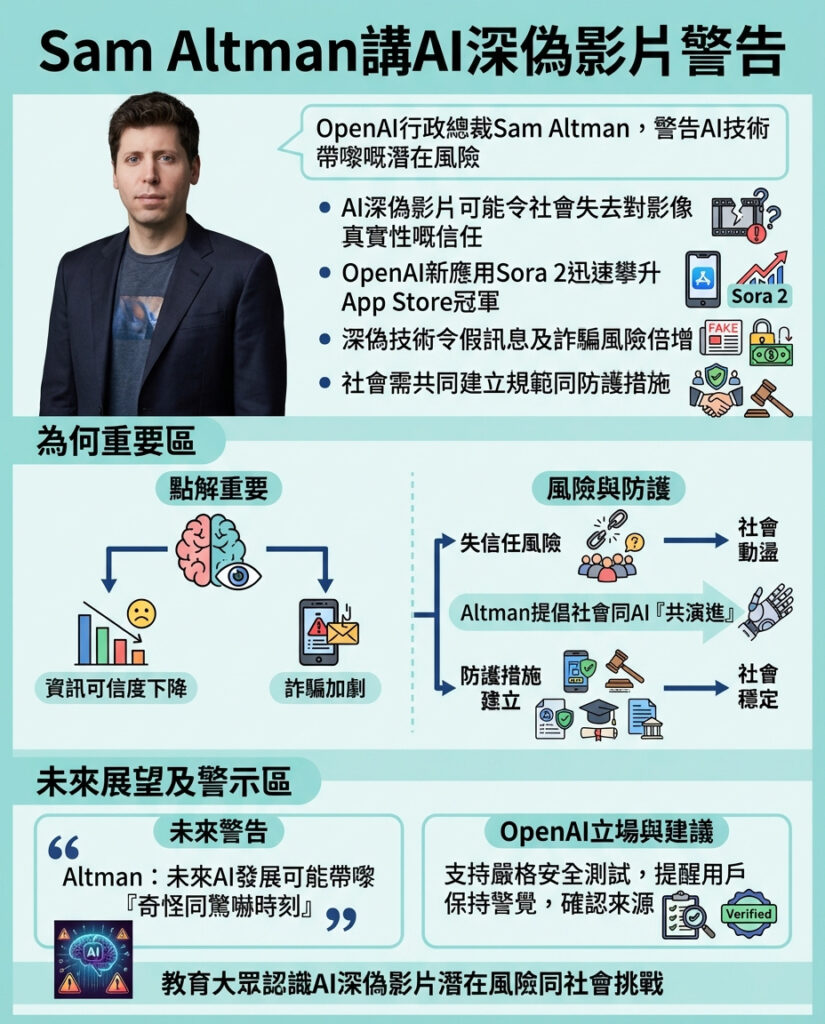

OpenAI行政總裁Sam Altman警告:AI深度偽造技術將帶來嚴重風險

OpenAI行政總裁Sam Altman最近於風險投資公司Andreessen Horowitz的a16z播客中發出警告,指人工智能(AI)技術,特別是深度偽造(deepfake)影片,將引發「非常嚴重嘅問題」,甚至帶來「奇怪同恐怖嘅時刻」。Altman表示,社會必須盡快學習如何建立防護措施,避免這些技術變得更強大後帶來不可控的後果。

OpenAI新推出的視頻應用程式Sora 2在上架蘋果App Store後迅速登上美國下載榜首,顯示深度偽造技術正迅速普及。社交媒體上開始出現由Sora製作的深度偽造影片,內容包括已故民權領袖馬丁·路德·金(Martin Luther King Jr.)以及Altman本人被描繪成涉入各種犯罪行為的假影片。OpenAI其後禁止用戶在Sora上製作馬丁·路德·金的影片,以免冒犯公眾。

為何Altman認為必須「共進化」?

Altman解釋,公司公開發佈這類技術的原因,是希望社會能夠「試車」,及早接觸這些驚人嘅視頻模型,因為未來幾乎任何人都可以被深度偽造,展示出任何想像得到嘅畫面。他認為,與其在幕後完美研發,不如讓社會與AI技術「共進化」,即在技術變得更強大之前,讓大家建立規範和防護機制。

Altman特別指出,深度偽造影片可能會摧毀我們長期以來視為真實的證據基礎,例如歷史事件的影像,這些影像曾經改變世界。然而,他樂觀表示,及早面對這些挑戰可以讓社會更好地準備應對未來更先進的工具。

深度偽造影片的危害與現實挑戰

有報告指出,Sora 2推出後不久,便有否認大屠殺的影片在Instagram獲得數十萬讚好,全球反仇恨與極端主義聯盟認為,OpenAI缺乏針對仇恨言論的明確政策,助長了網上極端內容的滋生。

Altman不僅擔憂假影片,還警告當大量人們將決策交給難以理解的算法時,可能會出現「奇怪或恐怖的時刻」。他形容「數十億人同時與同一個大腦對話」,可能引發難以預測的連鎖反應,迅速影響資訊流動、政治局勢及社會信任,這些變化可能遠超出任何人能控制的範圍。

儘管如此,Altman反對過度監管AI技術,認為大多數監管措施可能弊多於利,但他支持對「極度超人級」的AI模型進行「非常謹慎的安全測試」,並相信社會最終會發展出合適的防護措施。

深度偽造技術帶來的啟示與反思

Altman的立場顯示了科技領袖在推動新技術時的兩難:一方面要讓技術普及,促進創新與社會適應;另一方面又必須警惕技術帶來的潛在危害,尤其是對真實資訊的破壞和社會信任的侵蝕。深度偽造影片的出現,令我們必須重新審視「真相」的標準,並加快建立辨識假資訊的能力。

從香港的角度來看,這種技術可能加劇社會對媒體資訊的懷疑,尤其在政治敏感時刻,假影片可能被用作操控輿論或製造混亂。Altman提出的「共進化」概念,值得本地政策制定者和科技從業者深思:如何在技術推廣與風險管理之間取得平衡?更重要的是,如何教育公眾提升媒體素養,讓市民能夠更理性地判斷和使用資訊?

最後,Altman反對過度監管的觀點亦引發討論。在AI技術日益影響生活的今天,監管的尺度與方式需謹慎制定,既要防止技術濫用,又不扼殺創新活力。香港作為國際金融及科技樞紐,應積極參與全球對AI倫理與規範的討論,尋求符合本地實際的監管策略。

總結來說,OpenAI的Sora 2以及Altman的警告提醒我們,人工智能尤其是深度偽造技術的發展速度驚人,社會必須未雨綢繆,建立防範機制和倫理標準,才能在這場數碼革命中保障資訊的真實性和社會的穩定。

以上文章由GPT 所翻譯及撰寫。而圖片則由GEMINI根據內容自動生成。