麻省理工學院科學家研究臨床人工智能時代的記憶風險

最新研究顯示,人工智能模型可以透過測試,確保不會因為洩露匿名化的病人健康數據而造成傷害。

患者私隱的重要性由古至今都非常被重視。《希波克拉底誓言》中指出:「我在病人生活中所見所聞,無論是否與我的職業有關,凡不宜外傳之事,我必保守秘密,視之為私隱。」在數據驅動算法和網絡攻擊日益猖獗的今天,醫療領域仍是少數重視保密性的範疇,使病人能夠放心與醫生分享敏感資料。

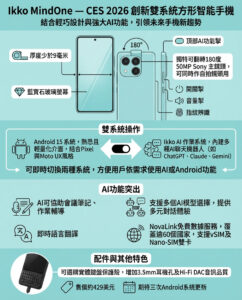

不過,麻省理工學院的研究團隊最近發表了一篇論文,探討訓練於去識別化電子健康記錄(EHR)的人工智能模型,可能會「記憶」個別病人的私人資料。該研究於2025年神經信息處理系統會議(NeurIPS)展示,提出一套嚴謹的測試方法,確保透過特定指令(prompt)無法洩露資訊,並強調必須在醫療背景下評估資料外洩是否真正影響病人私隱。

一般而言,基礎模型(foundation models)應該能從大量病人記錄中汲取知識,進而做出更準確的預測。但當模型「記憶」了單一病人資料並用於輸出時,便有可能侵犯私隱。事實上,基礎模型已被證實容易出現數據洩漏問題。

研究首作者、來自MIT-哈佛Broad研究所Eric and Wendy Schmidt中心的博士後研究員Sana Tonekaboni指出:「這些大容量模型的知識本可造福許多社群,但惡意攻擊者可透過特定指令誘導模型洩漏訓練數據。」她強調,鑑於此風險,這項工作是朝向實際評估措施邁出重要一步,確保模型公開前有完善的檢測。

為了評估訓練於EHR的基礎模型在醫療上的潛在風險,Tonekaboni與MIT電機工程與計算機科學系副教授Marzyeh Ghassemi合作,後者是Abdul Latif Jameel健康機器學習診所(Jameel Clinic)的主要研究員,領導專注於醫療領域穩健機器學習的Healthy ML小組。

研究團隊設計了一系列測試,試圖揭示惡意者需要多少資訊才能誘導模型洩漏敏感資料,並依據不同攻擊層次評估對病人的實際風險。Ghassemi教授表示:「我們特別強調實際情況,如果攻擊者必須知道你多項實驗室檢查的日期和數值才能成功竊取資料,那麼風險就很低。因為若他已經擁有這些受保護的原始數據,何必還要攻擊大型基礎模型?」

隨著醫療紀錄數碼化,資料外洩事件愈見頻繁。過去兩年,美國衛生與公共服務部記錄了747宗涉及超過500名個人健康資訊的數據洩漏事件,大部分因駭客或IT事故引起。

擁有罕見疾病的病人更易成為目標,因為他們的資料較易被識別。Tonekaboni表示:「即使是去識別化數據,洩漏的資訊種類也會影響識別風險。一旦識別出身分,攻擊者便可知道更多。」

測試結果顯示,攻擊者掌握的病人資訊越多,模型洩漏的可能性越高。研究團隊成功區分了模型的泛化表現與病人級別的記憶,從而更準確評估私隱風險。

論文同時指出,不同的資訊洩漏對病人的傷害程度不同。例如,模型洩露病人的年齡或人口統計資料,相較於洩露HIV診斷或酗酒問題,前者屬於較輕微的洩漏。

研究人員計劃將此項工作擴展至跨學科合作,邀請臨床醫生、私隱專家及法律專家共同參與。

Tonekaboni強調:「我們的健康資料之所以需要保密,是有道理的,沒有人有理由知道這些私隱。」

這項研究得到MIT-哈佛Broad研究所Eric and Wendy Schmidt中心、Wallenberg AI、Knut and Alice Wallenberg基金會、美國國家科學基金會(NSF)、Gordon and Betty Moore基金會、Google Research Scholar獎勵及Schmidt科學的AI2050計劃支持。研究資源部分由加拿大安大略省、省政府及Vector研究所贊助企業提供。

—

編輯評論與深入分析

這篇來自MIT的研究深刻揭示了在醫療人工智能領域,一個常被忽視但卻極其重要的隱憂——基礎模型可能會「記憶」甚至洩露病人敏感資料。隨著AI在醫療診斷、治療建議乃至健康管理的應用日益普及,資料保密性不再是純技術問題,而是攸關病人權益、倫理和法律的核心議題。

傳統上,我們認為去識別化數據已足夠保障病人私隱,但這項研究提醒我們,AI模型的「記憶」能力可能突破這層防線。這就像是把病人資料放入一個巨大的「黑盒」,模型在「學習」過程中不但吸收了通用知識,還有可能「背誦」了特定個案的詳細資訊。這種情況下,一旦模型被惡意誘導,私隱洩漏風險便大大提升。

研究團隊提出的分層測試框架,從實際攻擊的角度評估風險,極具前瞻性。它不僅考慮到技術層面,更結合了臨床實務中對病人資訊的敏感度不同,從而有助於制定更合理的安全標準和監管政策。這對於推動臨床AI技術的安全落地、增強公眾信任至關重要。

更值得注意的是,研究者呼籲跨學科合作,結合醫學、資訊安全、法律和倫理專家的智慧,這種多角度審視將有助於在技術創新與病人權益保護間取得平衡。未來的臨床AI發展,不能僅僅追求性能優化,更要在設計之初就融入隱私保護機制,實現「隱私保護的AI」。

總括來說,這項研究不僅為醫療AI的安全性提供了重要檢測工具,也為全球醫療數據治理和AI倫理提供了寶貴啟示。香港乃至全球的醫療系統,在推進數碼化和AI應用時,應該密切關注此類研究成果,確保技術進步不以犧牲病人私隱為代價。

以上文章由GPT 所翻譯及撰寫。而圖片則由GEMINI根據內容自動生成。