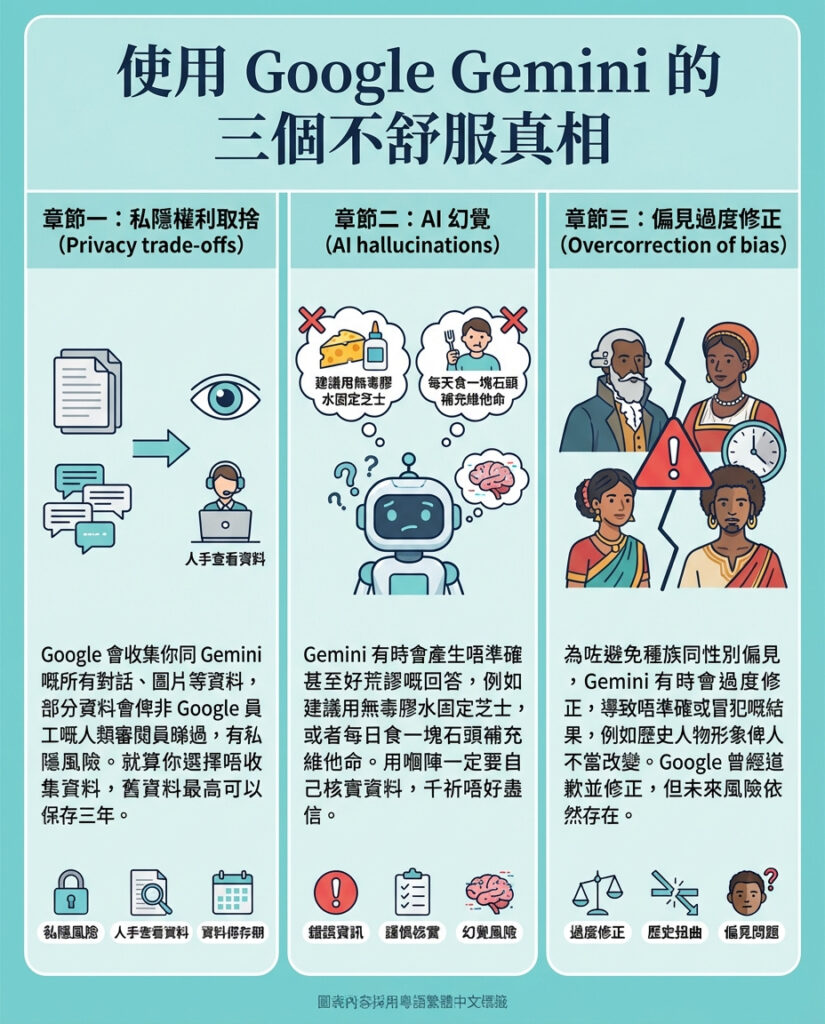

關於使用Google Gemini的3個令人不安的真相

Google Gemini——同其他生成式AI助理一樣——喺過去兩年非常受歡迎,主要因為佢被整合入Google多款熱門消費者產品,例如Google搜尋嘅AI模式同Android Auto嘅Gemini Live。佢支援多平台,可以幫你寫程式、解決複雜問題,甚至透過Nano Banana生成驚人嘅圖像。

不過,Gemini遠非完美,正如ChatGPT有啲不為人知嘅問題,Google嘅AI助理同聊天機械人都有啲缺點,係每個用家都應該知道嘅。佢唔一定準確,有時會出現「幻覺」——即係生成錯誤或虛假資訊,呢點同大部分生成式AI一樣。此外,為咗提升模型表現,Google會由真人審核部分用戶同Gemini嘅對話,牽涉到私隱問題。Gemini亦被指存在偏見同過度修正嘅問題。如果你認真想用Google Gemini,就要清楚佢嘅權衡與隱藏嘅現實。

私隱權衡

雖然Gemini帶嚟嘅便利令人著迷,但同時要注意私隱風險。Gemini嘅私隱政策明確指出,Google會收集你同AI助理嘅所有對話內容,包括文字、語音提示,甚至你分享嘅文件、相片、截圖同影片。佢亦會收集你使用Gemini應用嘅裝置資料。雖然大部分資料未必會被真人查看,但Google表示部分數據會由真人審核,其中有啲審核員甚至唔係Google員工。

即係話,如果你同Gemini分享敏感資料或私密對話,有其他真人可能會睇到,唔係淨係AI睇。當然,你可以選擇退出數據收集,但即使咁,Google都會保留數據72小時,用於安全同反饋處理。而且退出只適用於未來嘅對話,過去嘅對話雖然可以刪除,但如果曾被真人標記,Google可能會保存長達三年。

AI幻覺問題

Gemini喺Google搜尋嘅AI模式中前置展示,甚至常喺網頁結果之前出現,令用家無可避免會見到Gemini嘅回答。但要記住,Gemini嘅回應唔一定正確,呢點係公開嘅事實。你同Gemini嘅對話頁面會有提醒:「Gemini可能會犯錯,請自行核實。」儘管有警告,Gemini同其他AI聊天機械人自信地提供錯誤資訊,風險非常大,呢啲錯誤資訊甚至有專用名詞叫「AI幻覺」。

例如,Gemini曾建議用無毒膠水固定比薩上的芝士,又建議每日食一塊石頭來補充礦物質同維他命。現時冇方法完全避免呢啲幻覺,唯一方法係對Gemini嘅資訊保持懷疑態度。如果你用Gemini做創意工作之外嘅事,最好自己再核實資料。

偏見過度修正

為咗避免AI模型長期存在嘅種族同性別偏見,Google嘅Gemini AI嘗試做出調整,但有時反而過度修正,令結果出現不準確甚至冒犯性嘅內容。最出名嘅例子係2024年,有用戶用Gemini嘅圖像生成工具搜索歷史人物時,結果出現種族多元化嘅開國元勳、亞洲維京人,甚至有彩色人種穿住1940年代德國士兵制服嘅圖像。

呢種過度修正係因為系統「硬編碼」咗唔想只展示白人男性權威人物,但過度嘅修正可能導致歷史被扭曲。Google為此道歉,並試圖修正避免類似事件再發生,但未來唔能保證唔會再有類似嘅強硬做法。

—

編輯評論:

Google Gemini作為生成式AI嘅先鋒之一,固然帶來方便同創新,但呢篇文章深刻揭示咗背後嘅三大隱憂,尤其係私隱問題同資訊誤導,反映出現代AI產品嘅兩難困境。用戶享受AI帶嚟嘅效率與創意同時,亦要承擔被監控同誤導嘅風險。尤其係私隱層面,Google雖然有匿名化措施,但由真人審核數據嘅做法,令用戶敏感資料存在被曝光嘅可能,呢點喺香港同全球都引發不少討論。

AI幻覺問題提醒我哋,AI並非萬能真理機,凡事都要有獨立思考同多方核實。Gemini建議用膠水喺pizza上固定芝士,聽落荒謬,但喺真實世界中,類似錯誤可能引致嚴重後果,尤其係醫療、法律等領域。用戶應該建立「AI懷疑論」心態,避免盲目相信。

最後,偏見過度修正問題突顯AI倫理嘅複雜性。Google想避免偏見,但過度修正可能造成歷史扭曲,反映AI設計者需在多元包容與真實呈現之間取得平衡。呢個議題喺全球AI發展中都極具挑戰性,值得業界同公眾持續關注。

總括而言,Google Gemini仍處於發展階段,用家應該充分了解佢嘅限制與風險,理性使用,方能善用AI帶來嘅好處,避開潛在陷阱。對香港用戶而言,更應留意私隱條款,謹慎分享個人資料,避免不必要嘅風險。

以上文章由GPT 所翻譯及撰寫。而圖片則由GEMINI根據內容自動生成。