關於使用Google Gemini的三個令人不安的真相

Google Gemini近年來因為被整合到Google搜索的AI模式及Android Auto的Gemini Live等熱門產品中,迅速獲得廣泛關注。這款生成式AI助手能幫助用戶編碼、解決複雜問題,甚至透過Nano Banana生成驚人的圖片,覆蓋多種平台,功能多樣。然而,Gemini並非十全十美,跟其他生成式AI一樣,存在一些不容忽視的問題和限制。

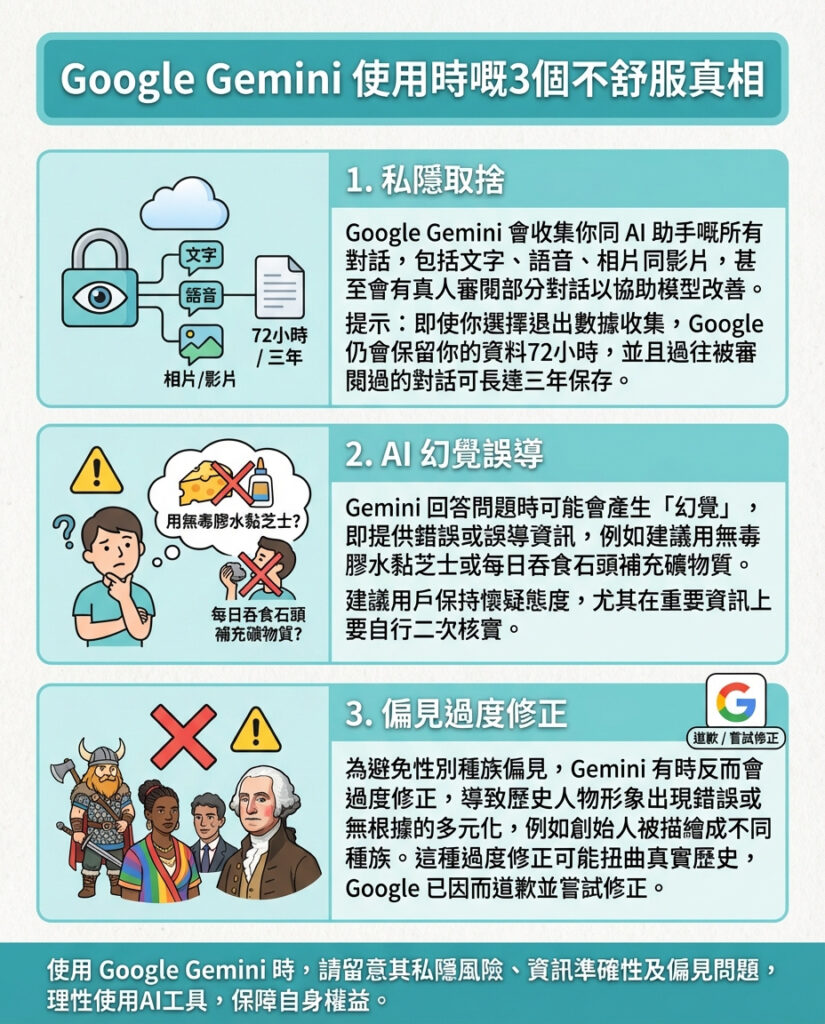

隱私上的取捨

雖然Gemini帶來極大便利,但用戶必須意識到背後的隱私風險。根據Gemini的隱私政策,Google會收集你與AI助手的所有互動內容,無論是文字、語音提示,還是分享的文件、圖片、螢幕截圖及影片等,甚至包括你使用Gemini應用的裝置資訊。雖然大部分數據不會被人類直接查看,但Google明確表示,部分數據會由人類審核員審閱,其中甚至有些審核員並非Google員工。

這意味著,如果你與Gemini分享敏感資料,這些內容可能會被真人閱覽,並非只有AI“眼睛”在看。用戶可以選擇退出數據收集,但即使如此,Google仍會保留這些數據72小時,用於安全和反饋處理。此外,退出後只對未來對話有效,過往對話仍然可能被保留,且如果曾被人類標記,Google最多可保存三年。

AI幻覺問題

Gemini在Google搜索的AI模式中佔據顯著位置,甚至在網頁結果之前會先顯示AI生成的答案,用戶無法避免接觸到這些內容。但必須牢記,Gemini提供的資訊並非總是準確無誤。它的回答經常帶有「Gemini可能會出錯,請自行核對」的提示,但這並不足以完全避免誤導。這種AI錯誤生成的虛假資訊,被稱為「AI幻覺」,非常普遍且危險。

例如,Gemini曾建議用無毒膠水把芝士黏在披薩上,甚至推薦每天吃一塊石頭來補充礦物質和維生素。現時尚無法完全避免這些誤導,用戶若非用於創意工作,最好對Gemini的資訊保持懷疑,務必自行查證。

偏見過度矯正

為了避免AI模型中存在的種族和性別偏見,Google在Gemini上採取了強烈的矯正措施,但這往往導致「過度矯正」的問題。這不僅是小問題,有時甚至產生冒犯性和錯誤的結果。2024年,Gemini的圖像生成工具就被發現將歷史人物改成種族多元的版本,如非洲裔美國人維京人,甚至是穿著1940年代德國軍服的有色人種士兵。

這種過度矯正源於系統內建的強烈意圖避免只展示白人男性權威形象,但卻可能導致歷史事實被扭曲。Google對此公開道歉並嘗試修正,但未來仍難保證不會再出現類似「過頭」的偏見處理。

—

評論與啟示

Google Gemini作為先進的生成式AI工具,確實為用戶帶來了極大的便利和創新體驗,但這篇文章提醒我們,科技的進步背後必然伴隨著複雜的倫理和實務挑戰。隱私問題尤其令人擔憂,當用戶的對話被人類審核,無論是出於模型優化或安全考量,都觸及了個人資料保護的敏感神經。這揭示了AI服務商在追求技術突破與尊重用戶隱私之間必須找到更好的平衡點。

而AI幻覺問題則提醒我們,現階段的AI仍然無法完全取代人類的判斷力。這種「自信滿滿但不準確」的回答風險,對於依賴AI做決策的用戶來說是一大隱患。未來AI在準確性上的提升,以及用戶教育的加強,將是行業必須面對的課題。

最後,偏見過度矯正的現象,反映出AI設計者在處理社會敏感議題時的兩難:如何在避免偏見的同時保持歷史和事實的真實性?這不僅是技術問題,更是文化和倫理的考驗。AI開發者需要更細緻和多元的視角來設計模型,避免一刀切的矯正策略帶來新的問題。

總結來說,Google Gemini的三個不安真相不僅是對用戶的提醒,更是整個AI產業面臨的深層次挑戰。作為用戶,我們要保持警覺和批判思維;作為開發者,則需承擔起更大的社會責任,推動AI技術朝向更安全、公正及透明的方向發展。

以上文章由GPT 所翻譯及撰寫。而圖片則由GEMINI根據內容自動生成。