解釋性與人類監督:人工智能問責制的互補關係

連續第四年,麻省理工學院斯隆管理評論(MIT Sloan Management Review)與波士頓諮詢集團(BCG)攜手組建了國際人工智能專家小組,涵蓋學術界與實務界,深入探討全球範圍內企業如何實踐負責任的人工智能(Responsible AI,簡稱RAI)。2025年春季,我們同時進行了一項涵蓋1,221名全球高管的調查,了解組織在負責任AI方面的進展。今年首篇文章聚焦於通用人工智能生產者的問責制,而本文則重點探討解釋性(explainability)與人類監督(human oversight)之間的關係,以及它們如何共同促進AI系統的問責。

在AI治理領域,解釋性指的是能為人類提供清晰、易懂且有意義的解釋,說明AI系統為何會做出某個決策。它與技術層面的可解釋性(interpretability)密切相關,但範圍更廣,後者偏重於理解模型輸入如何影響輸出。兩者皆旨在提升日益複雜且不透明的AI系統的透明度,並已體現在近期的監管規範中。例如,歐盟《人工智能法案》要求高風險AI系統必須設計成便於有效的人類監督,並賦予個人獲得「清晰且有意義解釋」的權利。南韓的全面AI法也針對醫療、能源及公共服務等「高影響」領域的AI系統提出類似解釋義務。企業為應對這些要求,紛紛推出商業治理方案,僅解釋性市場預計到2028年將達162億美元。

針對解釋性與人類監督是否可以互相替代的問題,我們向專家小組提出挑戰性陳述:「有效的人類監督降低了AI系統對解釋性的需求。」結果顯示,77%專家不同意此說法,認為解釋性與人類監督是互補而非競爭的AI問責面向,兩者並非相互抵銷。

除了幫助人類掌控AI輸出,專家們強調解釋性還承載著信任、透明、公平與正當程序等社會核心價值。缺乏解釋性,人類監督淪為形式上的蓋章,威脅這些價值。然而他們也承認,解釋性在實務上有其限制。以下我們將分享專家見解,並結合自身在負責任AI領域的經驗,提出強化AI問責的建議。

解釋性與人類監督是AI問責的互補支柱

多數專家認為,有效的人類監督並不減少對解釋性的需求。Data Privacy Brasil創辦人Bruno Bioni指出:「解釋性與人類監督是AI治理框架中互補且交織的保障。」新加坡國立大學Simon Chesterman亦表示:「監督與解釋性不是競爭價值,而是負責任AI治理相輔相成的支柱。」e&的Renato Leite Monteiro強調兩者是互補力量,Intel Labs的Elizabeth Anne Watkins總結道:「兩者協同工作。」

Harman Digital Transformation Solutions的Jai Ganesh強烈反對「有效人類監督降低解釋性需求」的說法,他認為解釋性提升用戶信任、問責與知情同意,能幫助識別偏見及確保系統安全可靠。有效監督與解釋性應並行,是負責任AI部署的必要條件。

ForHumanity的Ryan Carrier說明:「人類監督與解釋性用途迥異,不能互相取代。」聯合國大學Tshilidzi Marwala也認為兩者是不同但強力協同的概念。阿爾伯塔機器智能研究所的Alyssa Lefaivre Škopac指出:「監督確保AI安全負責,但若監督者不了解AI決策原理,調整系統將困難重重。」澳洲國立大學Belona Sonna補充,解釋性「有助於監督者洞察模型運作,識別偏見及不公平現象。」EnBW的Rainer Hoffmann則強調,解釋性幫助開發者除錯、監管者確保合規及企業管理風險。

H&M Group的Linda Leopold認為,有效人類監督依賴解釋性,確保系統按預期運作。Carrier指出監督是干預、控制、調整與風險管理的基礎。史丹福大學Riyanka Roy Choudhury認為解釋性使人類能作出有根據的判斷,信任或推翻AI決策。IAG的Ben Dias認為解釋性協助用戶理解結果及發現異常,人類監督則防止AI出錯並確保系統正常運作。

解釋性助推社會核心價值,防止監督淪為蓋章

專家們一致認為,解釋性不只是實務工具,更反映了自治、公平、正當程序與問責等深層社會價值,這些是人類監督無法單獨實現的。Monteiro說:「解釋性賦予個人理解及挑戰自動決策的權利,是隱私與數據保護框架中的基本權利,也是建立自動化系統信任的基礎。」Marwala指出:「監督是即時風險的關鍵防護,但解釋性帶來更深遠的透明與信任,支撐良好治理。」

RAIght.ai的Richard Benjamins以醫療為例,醫生不應接受無法理解原因的AI診斷,因AI會出錯。Nasdaq的Douglas Hamilton則說,人類尋求的是與直覺或專業知識相符的解釋,而非純計算式的數據。

調查結果概覽

對陳述「有效人類監督降低AI系統解釋性需求」的回應中,3.3%強烈同意,0%同意,20%中立,36.7%反對,40%強烈反對。

Automation Anywhere的Yan Chow說:「AI與人類監督意見不合時,解決方案需透過理解AI推理。缺乏解釋性,便是人類直覺對抗黑盒算法,雙方無法互相學習。真正的人機協作需要相互理解。」DBS Bank的Sameer Gupta警告,缺乏解釋性的人類監督只是形式,淪為蓋章。National University of Singapore的Chesterman亦提醒,系統不透明會讓人類監督淪為虛設。OdiseIA的Idoia Salazar強調,信任AI不應只靠監督,更需透明與可解釋系統,特別在醫療、金融與司法領域。這些觀點也呼應了歐盟AI法案對高風險系統的要求。

實務中解釋性有限制

專家同時指出,解釋性並非在所有情境都可行或必要。渣打銀行David R. Hardoon強調解釋性需求應視對象與目的具體定義。赫爾辛基大學Teemu Roos指出,解釋性形式多樣,現代AI系統複雜度高,傳統解釋方式難以適用。Apollo Global Management的Katia Walsh甚至認為「AI解釋性是一種謬誤」,因AI系統複雜度媲美人腦。Škopac強調,無法解釋時,「強有力的監督與領域專業知識」更為重要。

另一方面,Instalily.ai的Amit Shah認為「有效人類監督使傳統解釋性變得無關緊要」,他支持透過實證審核、紅隊測試與即時人工覆核保障安全,認為「過度強調解釋性只會拖慢創新,製造虛假的控制幻象。」

建議

綜合專家意見,我們提出以下建議,助企業透過人類監督與解釋性實現有意義的AI問責:

1. 設計AI系統以支持有效人類監督。系統應能提供決策證據、詳細審計與變更日誌,監控拒絕率,標記需升級決策,並以信心分數等指標呈現結果。

2. 培養人類監督能力。用戶須接受全面AI教育,瞭解系統限制、偏見與故障模式,才能做出明智判斷與適時介入,確保問責。

3. 監督過程中須涵蓋多種解釋性。關鍵場合(如醫療診斷)需經常審查AI解釋,其他場合可較少。企業應思考何時需解釋性,避免「解釋性作秀」。

4. 避免控制幻象。解釋性與監督只有在帶來真實理解與問責時才有意義。過度強調可能造成虛假安全感,監督淺嘗輒止則流於形式。企業應根據實際情境靈活調整策略。

—

編輯評論與觀點

本文深入剖析了人工智能治理中的兩大核心支柱:解釋性與人類監督,並通過國際專家意見與全球調查數據,強調兩者並非對立,而是相輔相成。這種看法對香港及全球科技發展均具重要啟示。

在AI技術日益融入日常生活及關鍵決策的當下,單靠人類監督或純粹依賴技術透明度均難以保障問責。解釋性不僅是技術需求,更是社會信任的基石,有助於用戶理解與接受AI決策,防止監督淪為形式,保障公平與正當程序。反之,強調解釋性同時也應避免陷入「解釋性作秀」,務必結合監督實務與專業知識,確保AI行為符合倫理與法律標準。

香港作為國際金融與科技樞紐,面對AI監管挑戰時,應借鑒此類國際趨勢與專家建議,推動本地企業提升AI治理能力,培養具備AI素養的監督人才,並建立靈活且具體的解釋與監督機制。這不僅提升企業競爭力,也有助於增強公眾對AI技術的信任,促進科技與社會的和諧發展。

最後,對於AI解釋性的限度與未來發展,香港社會與政策制定者應保持開放態度,鼓勵跨界合作與創新,探索平衡技術複雜度與人類可理解性的最佳方案,確保AI技術既安全可靠,又能切實服務於人類福祉。

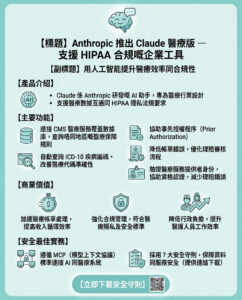

以上文章由特價GPT API KEY所翻譯及撰寫。而圖片則由FLUX根據內容自動生成。