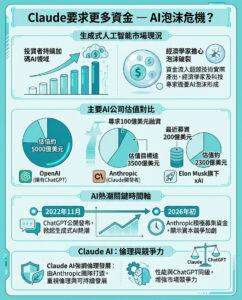

AI懷疑者Gary Marcus談AI的道德和技術缺陷

認知科學家Gary Marcus認為,當前的AI環境對於我們作為消費者和社會來說,並未達到應有的標準,但他相信改變的時機尚未過去。

Marcus是紐約大學心理學和神經科學的名譽教授,著作頗豐,並共同創辦了Geometric Intelligence,這是一家後來被Uber收購的AI初創公司。如今,他卻被廣泛視為AI領域的尖銳批評者。科幻作家Kim Stanley Robinson稱他為「我們少數幾位不可或缺的公共知識分子」;而AI界的巨頭Yann LeCun和Geoffrey Hinton則與他進行過公開辯論。即便如此,OpenAI的CEO Sam Altman也曾對他進行過模糊的抨擊,指責他是「平庸的深度學習懷疑者」。

Marcus的批評不僅限於技術本身,還涉及到道德層面的問題。他提到,當前AI系統的設計未能區分重要與不重要的任務,導致其在提供答案時頻繁出錯。他引用軍事界的一句話:「經常錯誤,卻從不懷疑」,來形容大型語言模型(LLMs)的表現。這些模型在表達上似乎充滿權威性,卻常常無法提供真實的信息。

技術的不足

Marcus在2022年發表的文章《深度學習遇到瓶頸》中,指出深度學習的認知能力仍未達到真正智能代理的標準。他認為,儘管對該領域的資金投入驚人,但在計劃、推理和事實與虛假資訊的區分等核心能力上,並沒有實質性進展。他表示:「這些問題仍未得到解決。」

Marcus在其Substack上詳細記錄了當前AI系統的失誤。例如,Meta的Galactica AI曾錯誤聲稱Elon Musk於2018年死於車禍,這顯示了模型在處理事實方面的嚴重不足。他指出,這種錯誤的根本原因在於AI依賴於模式匹配,而非真正的推理能力。

此外,Marcus還提到AI在引用現有資訊時的可靠性問題。曾有律師提交了一份由ChatGPT撰寫的法律文件,結果發現多個引用的案例實際上是虛構的。這些問題進一步表明,AI在提供資訊上的不可靠性對用戶造成了潛在傷害。

道德缺陷與行業責任

Marcus對AI行業的道德缺陷表示擔憂。他強調,許多AI公司在訓練其模型時,未經授權使用了大量受版權保護的材料,這不僅涉及法律問題,也涉及對創作者的道德責任。他質疑,是否應該允許AI公司在未經同意或公平補償的情況下使用藝術家的作品。

同時,Marcus也對行業對監管的抵制表示不滿。他指出,儘管矽谷有許多人對AI的潛在風險表達了擔憂,但行業仍然在努力削弱監管法律的影響力。他認為,政府應該更努力地讓獨立科學家和倫理學家參與到相關的法律制定中。

Marcus呼籲用戶和公民采取行動,推動更好的透明度和監管,以確保AI技術能真正造福社會。他強調:「如果我們不解決當前道德上的缺陷,可能會引發對整個AI領域的反彈。」

結語

儘管Marcus對當前AI技術的批評似乎使他成為了反對者,但他實際上對技術的潛力抱有希望。他認為,AI應該能夠更安全地發展,以避免造成潛在的社會問題。最終,Marcus的目標是促進一種更好的AI形式,使其真正能夠為大眾服務,而非少數利益集團的工具。

在這個快速發展的科技時代,Marcus的觀點提醒我們,必須對AI技術的發展保持警惕,並確保其不僅僅是在技術上進步,更要在道德和社會責任上有所作為。

以上文章由特價GPT API KEY所翻譯及撰寫。而圖片則由FLUX根據內容自動生成。