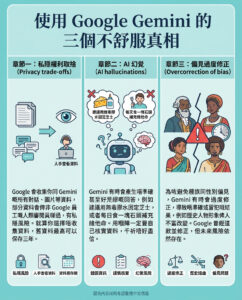

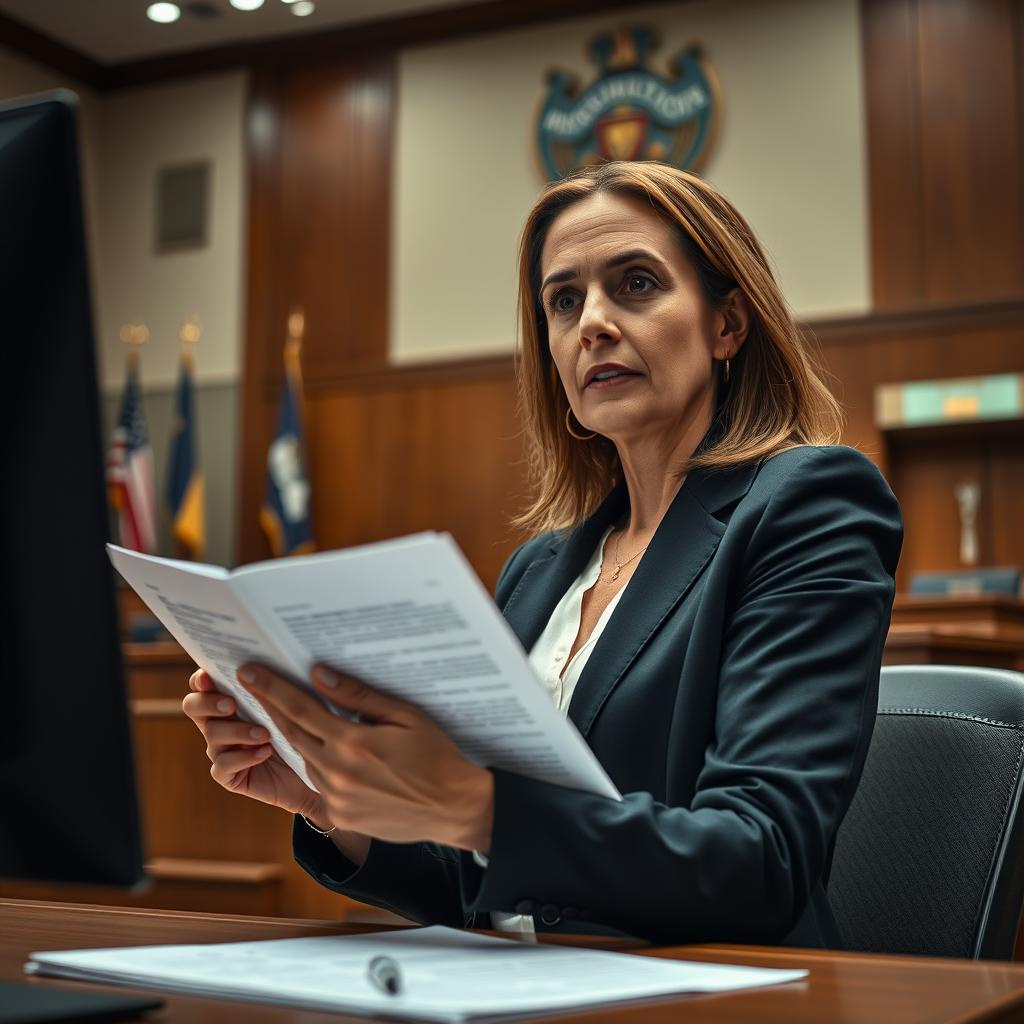

達拉斯律師引用法庭未曾聽聞的案例,疑似由人工智能捏造?

一名企業律師海蒂·哈弗(Heidi Hafer)去年五月向德州第五區上訴法院提交了一份近50頁的法律文書,挑戰法庭沒收她價值百萬美元珠寶的裁決,她聲稱該珠寶是用來償還家族債務的禮物。哈弗雖是律師,但對上訴法庭程序並不熟悉。為支持其主張,她引用了31宗法庭案例,包括1979年泰勒法院的Macy’s Texas, Inc.訴D.A. Adams & Co.案、1958年的Stephens訴Beard案、1896年的Gaston訴Monroe案,以及1996年聖安東尼奧的Estate of Malpass訴Malpass案。

然而,無論是達拉斯上訴法院、債權人律師,還是哈弗本人,均未能找到上述四宗案例,因為這些案例根本不存在。

哈弗現正面臨可能的制裁,指控她在準備法庭文件時使用了生成式人工智能(AI)。她在上月提交給上訴法院的一份四頁報告中,承認全部錯誤由自己承擔。

在周四上午的聽證會上,哈弗表示:「這是我第一次撰寫法律文書,我真的不知道如何處理,所以盡力而為。」當被問及為何未即時回應案件造假的指控時,她如此解釋。

哈弗自1999年起在德州執業,未曾被律師公會處分。她目前擔任一家與人工智能相關達拉斯公司的首席法律顧問。

代表哈弗出庭的前上訴法官、德州律師公會負責人工智能法務工作小組主席約翰·布朗寧(John Browning)表示,哈弗並非試圖掩飾錯誤,亦未推卸責任。他向三名法官表示,哈弗已充分承擔責任,並深感尷尬,且正著手自我提升,避免未來再犯。

哈弗告訴法官,她當時是利用Google搜尋有關贈與法的普通法,並不記得使用其他AI工具。事實上,Google本身亦有聊天機械人及AI生成的搜尋摘要。

布朗寧向《達拉斯晨報》表示:「人工智能已無處不在,很多人未必意識到它在生活中的普遍性。」

哈弗及債權人JGB Collateral, LLC的律師均拒絕置評。

隨著美國律師協會發布人工智能使用指引,德州律師公會亦推出框架,提醒律師必須核實AI生成內容的準確性。北德州至少三名聯邦法官要求律師確認AI草擬的語句經過核實,州內多個地區法院亦有類似規定。

北德州大學達拉斯法學院教授科林·蒙斯特曼(Korin Munsterman)指出:「律師有專業能力的責任,其中包括技術能力。律師必須依靠自身專業知識,不能盲目接受生成式AI的結果。」

儘管AI可助律師簡化繁複或乏味的法律工作,甚至減少計費時間,但2024年一項調查顯示,68%的律師每週至少使用一次生成式AI。然而,AI生成錯誤或誤導性信息的問題依然嚴重。斯坦福大學研究指出,專為法律設計的AI工具錯誤率介乎17%至34%。

這並非首次有律師因AI誤導而陷入麻煩。美國多地律師曾因引用AI「幻覺」出來的虛假案例而被懲戒,包括德州布拉索斯縣、紐約及科羅拉多。前特朗普律師麥可·科恩亦曾因AI生成的虛假案例差點受罰。

布朗寧主張哈弗不應再受懲罰,稱其為「誠實錯誤」。「哈弗並無意誤導法庭,相關法律理據是真實存在的,她只是引用了不存在的案例。」

法官何時作出裁決仍未明朗。

—

評論與思考:

這宗案件揭示了生成式AI在法律實務中帶來的嚴峻挑戰。律師作為法律專業人士,必須對所引用的案例和法律依據負責,但AI「幻覺」現象讓真憑實據變得模糊不清,甚至可能誤導整個司法過程。哈弗律師的經歷,從一個初次嘗試上訴程序的企業律師角度,反映出即使是有經驗的法律從業者,也可能因過度信賴科技而犯下致命錯誤。

這同時呼喚法律界對AI的使用建立更嚴格的倫理和操作規範,並強調「人腦監督」的重要性。技術本身並非萬能,律師必須具備足夠的技術素養與批判思維,才能在AI輔助下,維護法律的嚴謹與公正。

此外,這件事亦提醒我們,AI技術的普及並非只有便利與效率,還帶來潛在的風險與責任。法律行業作為社會公正的守護者,更應該在AI應用上保持警惕,不能讓科技成為誤導或欺瞞的工具。未來,法律教育與職業培訓中加入AI倫理與風險管理,將是不可或缺的環節。

總括來說,這宗事件不僅是個別律師的失誤,更是AI與法律結合過程中,整個行業需正視和解決的現實問題。如何平衡科技發展與專業操守,將決定法律職業的未來走向。

以上文章由特價GPT API KEY所翻譯及撰寫。而圖片則由FLUX根據內容自動生成。