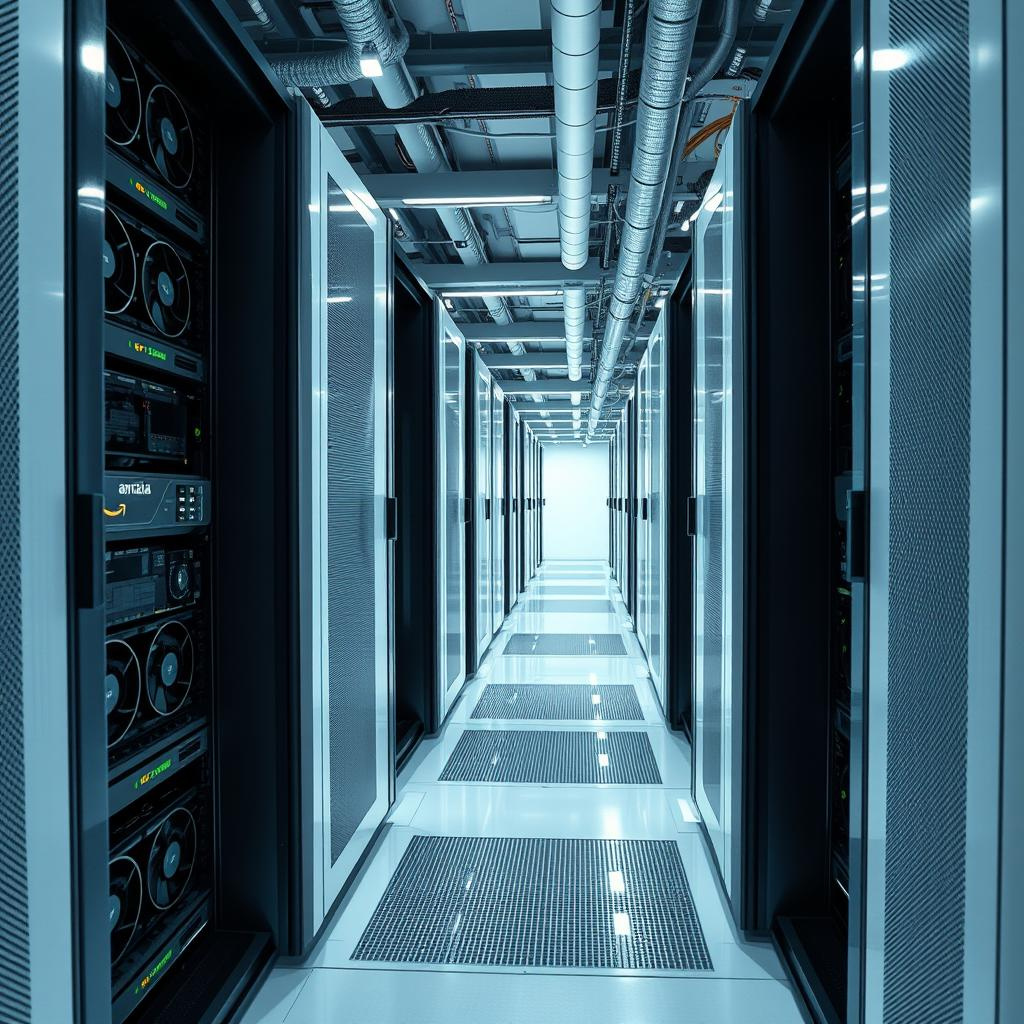

亞馬遜網絡服務推出專為Nvidia AI晶片打造的自家冷卻系統

亞馬遜網絡服務(AWS)於周三宣布推出一款全新自家研發的冷卻硬件,專門為Nvidia最新一代用於生成式人工智能系統的圖形處理器(GPU)而設計。

AWS開發了名為「In-Row Heat Exchanger」(IRHX)的定制基礎設施解決方案,選擇不採用業界普遍使用的液冷標準方案。這種創新設計讓AWS能夠在不需大規模改建數據中心的情況下,容納Nvidia高密度GPU機架。

Nvidia的Blackwell GPU專為大規模AI訓練與推理而設,耗能巨大且產生大量熱量,對冷卻系統要求極高。傳統的空氣冷卻方法已無法應付如Nvidia GB200 NVL72這類將72顆GPU集成於一個機架中的散熱需求。

AWS計算與機器學習服務副總裁Dave Brown在介紹影片中表示:「傳統方案會佔用太多數據中心空間,或者大幅增加用水量。雖然這些方案在其他供應商的較小規模應用中可能可行,但對我們這種規模來說,液冷容量遠遠不夠。」

IRHX冷卻系統結合了液冷與空氣冷卻技術以達致高效散熱效果。AWS與Nvidia合作研發,通過冷板將冷卻液循環至GPU晶片,再由風扇線圈陣列排出熱量,同時保持AWS標準機架的空氣冷卻機械結構。

這項冷卻創新與AWS新推出的計算實例EC2 P6e和P6e Ultra同步問世。這兩款實例分別提供客戶使用Nvidia HGX B200和GB200 NVL72堆疊,後者是AWS迄今最強大的伺服器配置之一,專門用於先進的AI模型開發與部署。

AWS亦強調了其Nitro基礎架構平台,該平台為新實例提供網絡與系統監控支援。Nitro系統允許在不中斷服務的情況下進行韌體更新,並支援每台Ultra伺服器高達28.8 TB/s的網絡帶寬,這對於跨越數萬顆GPU的大型AI工作負載至關重要。

—

評論與深入分析

AWS此次推出的IRHX冷卻方案,展示了其在AI基礎設施領域的技術創新與自主研發能力。面對Nvidia Blackwell GPU帶來的龐大熱量挑戰,AWS沒有選擇市場上現成的液冷技術,而是打造出結合液冷與空冷優勢的混合方案,既節省數據中心空間,也避免了用水量激增的問題,這對環保和運營成本控制都相當重要。

更關鍵的是,這種設計不需大規模改造現有機房,對AWS快速擴展AI運算能力具有戰略意義。隨著生成式AI需求激增,能否有效且高效地冷卻高密度GPU,將成為雲服務商競爭的核心技術門檻。

此外,AWS同步推出的強大計算實例和Nitro平台,展現了其端到端AI雲端方案的雄心。Nitro系統高達28.8TB/s的網絡帶寬,為分散式AI訓練提供了堅實基礎,這對未來大規模模型訓練和推理的性能提升至關重要。

對香港及亞洲市場來說,AWS此舉意味著雲端AI服務的硬件基礎正迅速升級,未來更多先進AI應用將可透過AWS平台落地,推動本地科技創新和產業升級。這也提醒本地企業和開發者,選擇雲端服務時除了軟件生態,更應重視底層硬件與基礎設施的先進程度,才能在AI競賽中保持優勢。

總結來說,AWS的自家冷卻技術不僅是硬件創新,更是對AI服務未來發展趨勢的前瞻布局,值得業界密切關注。

以上文章由特價GPT API KEY所翻譯及撰寫。

🎬 YouTube Premium 家庭 Plan成員一位 只需 HK$148/年!

不用提供密碼、不用VPN、無需轉區

直接升級你的香港帳號 ➜ 即享 YouTube + YouTube Music 無廣告播放