🎬 YouTube Premium 家庭 Plan成員一位 只需

HK$148/年!

不用提供密碼、不用VPN、無需轉區

直接升級你的香港帳號 ➜ 即享 YouTube + YouTube Music 無廣告播放

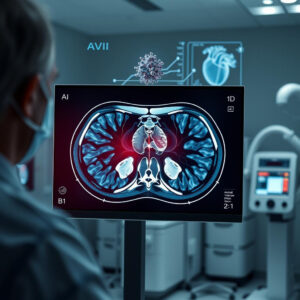

OpenAI最新研究顯示其AI模型準確率驚人地低

OpenAI最近發布的AI模型在提供正確答案方面表現得相當糟糕。根據其新推出的基準測試“SimpleQA”,OpenAI揭示了其最新模型在準確性上的嚴重不足。該公司的最新尖端模型o1-preview在這項測試中的成功率僅為42.7%,這意味著即使是最近宣佈的最佳大型語言模型(LLMs),提供錯誤答案的可能性也遠高於正確答案。這一發現令人擔憂,特別是在這項技術已開始影響我們日常生活的各個方面。

競爭者模型更糟

與此同時,競爭對手的模型,如Anthropic的Claude-3.5-sonnet,則在OpenAI的SimpleQA基準測試中表現得更差,僅有28.9%的問題回答正確。不過,這個模型在面對不確定性時更傾向於拒絕回答,這樣的選擇在目前的情況下可能是明智的。

更糟的是,OpenAI發現其AI模型往往過高估計自己的能力,這種特徵會導致它們對自己編造的虛假信息表現出高度的自信。大型語言模型長期以來都存在“幻覺”現象,這是一個優雅的術語,用來形容這些模型產生完全不實答案的傾向。

儘管這些模型產生完全虛構答案的可能性非常高,世界仍然熱烈擁抱這項技術,從學生生成作業到科技巨頭的開發人員生成大量代碼。

然而,問題的裂痕開始顯現。例如,最近有一款基於OpenAI技術的AI模型在醫院中被發現經常出現幻覺和不準確的情況,特別是在轉錄病患互動時。

美國各地的警察也開始使用AI,這一發展令人擔憂,可能導致執法機構錯誤指控無辜的人,或加劇現有的偏見。

OpenAI的最新發現再次令人擔憂,表明目前的LLMs在可靠地傳達真相方面能力不足。這一發展提醒我們,對任何LLM生成的輸出都應保持懷疑態度,並願意仔細檢查生成的文本。

無論這個問題是否可以通過更大的訓練數據集來解決——這是AI領導者們急於向投資者保證的事情——仍然是一個未解的問題。

評論

這篇報導突顯了當前AI技術中的一個重要問題:即使是最先進的模型,也可能在真實應用中表現不佳,這不僅影響了使用者的信任,也可能對社會造成更大的風險。尤其是在醫療和執法等關鍵領域,AI的錯誤會導致不必要的後果。未來的發展需要更加注重模型的準確性和可靠性,而不僅僅是推廣其應用。這不僅是技術的挑戰,更是倫理的考量。對於AI的進一步發展,我們需要一個更全面的監管框架,以確保其安全、有效地服務於社會。

以上文章由特價GPT API KEY所翻譯及撰寫。而圖片則由FLUX根據內容自動生成。