人類監督AI已經行到盡頭,係時候由AI來監控AI

多年以來,「人類介入監督」(Human-in-the-loop)一直係人工智能治理嘅標準做法,聽落去好合理、負責任又熟悉。但呢個說法而家已經唔啱。

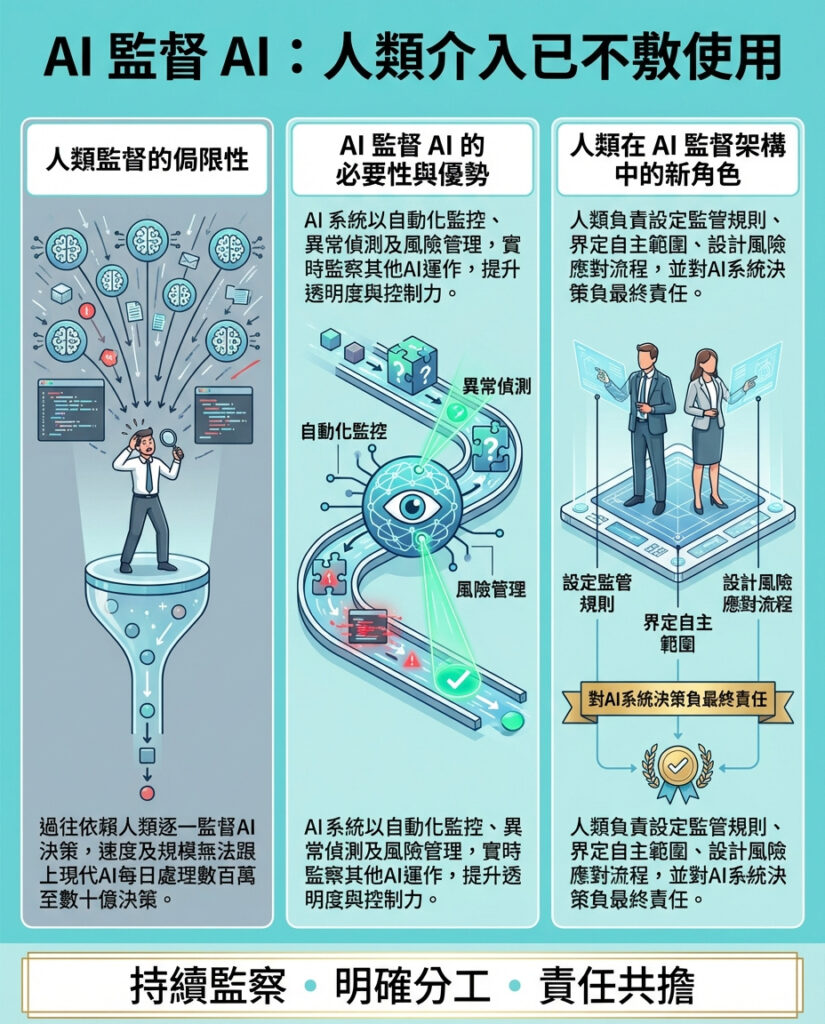

我哋已經踏入一個AI自主決策嘅年代,AI系統每秒鐘喺防欺詐、交易、個人化推薦、物流、網絡安全同自動化流程等領域作出數以百萬計嘅決定。喺呢種速度同規模下,話人類可以逐一監督AI嘅每一個決定,已經唔現實,只係一個安慰自己嘅幻想。

專家提醒,傳統嘅人類審查模式正喺生成式及自主系統由實驗階段走向商業應用時崩潰。政策同學術研究都指出,「人類監督」通常係一個理想化嘅概念,無法隨住AI決策嘅數量同速度擴展。

對科技領袖嚟講,呢點嘅含義好明顯:人類根本無法以機器嘅速度同規模,做到有效嘅監督。

咁就帶出一個更難嘅問題:「AI應該由AI嚟監管嗎?」

人類介入監督面臨擴展困難

人類介入監督嘅治理模式係為咗以前嗰啲演算法偶爾作出高風險決策,當時人可以用充足嘅時間同背景知識去審查。今時今日,AI系統係持續運作,永遠在線。

一個反欺詐模型可能每小時評估數百萬筆交易,一個推薦引擎可能每日影響數十億次互動。自主代理人會無需人類提示或檢查,自動串連多個工具、模型同API。

然而監督方法卻往往停留喺人工、定期同事後審查。研究建議人類同自動化監督結合,但很少有方案能夠應付大規模運作。

工程團隊早已明白呢點。監控同風險管理領袖視持續、自動化監測為基本要求,因為人工審查無法跟上模型漂移、數據污染、提示攻擊或新興行為。

冇一個認真嘅科技領袖會相信,每星期檢查一次或抽樣審計,就能真正監管每秒鐘演變數千次嘅系統。

更麻煩係AI嘅非確定性特質同無限嘅輸出。

人類監督已經失效

呢唔係假設未來嘅問題,而係現實:以人為中心嘅監督已經喺實際應用中失效。

當自動化系統出事,例如金融市場嘅閃崩、數字廣告無限燒錢、自動鎖戶口或者病毒式內容傳播,失敗往往喺人類察覺之前已經擴散。

好多時候,人類仍然「喺循環中」,但循環太慢、太零散或者太遲。殘酷嘅事實係,人類審查最多只係喺事後解釋機器速度引發嘅失敗。

自主系統令風險更大。想像一個有數十甚至數百個節點嘅多步驟代理工作流程,結果係一大堆複雜行動記錄,根本無人能夠逐一理解。咁樣要人工識別風險、行為漂移或意外後果基本上不可能。

監督研究質疑傳統人類監督喺高速大量決策中是否可行,呼籲以自動化監督機制,與所監控系統同速運作。

隨著AI系統愈來愈複雜,領袖必須依靠AI本身去識別、保護及執行AI同代理人嘅行為。

架構轉變:AI監控AI

呢個唔係話要人類退出治理,而係要將人類同AI放喺最能發揮價值嘅位置。

現代AI風險框架日益建議,喺AI生命週期中嵌入自動監控、異常檢測、漂移分析同政策執行,而唔係靠人工審查。

以NIST AI風險管理框架為例,將AI風險管理視為一個不斷循環嘅生命週期,包括治理、映射、測量同管理,持續監控同自動警報係核心要求。

呢啲推動咗AI可觀察性(AI observability)嘅興起:用AI持續監控其他AI系統,實時監察性能下降、偏見變化、安全異常同政策違規,並將重大風險升級俾人類。

呢啲唔係盲目信任AI,而係提升可見性、速度同控制力。

人類作為策略制定者及系統架構師

將監控任務交俾AI,不等於人類責任消失,而係責任重新分配。

呢點係信任經常崩潰嘅地方。有人擔心AI監控AI好似警察自我監管,呢個比喻只成立喺監督係自我參照且不透明嘅情況。

有效嘅模式係分層架構,權力分明:

– AI系統唔會自我監控,治理係獨立嘅;

– 規則同閾值由人類定義;

– 所有行動都會記錄、可查驗同可逆轉。

換句話講,就係一個AI監察另一個AI,但係喺人類定義嘅約束下運作,呢個模式與內部審計、安全運作同安全工程嘅規模化管理類似。

責任唔會消失,只會上移

人類唔再逐一審查輸出,而係設計系統、制定運作標準同政策、定義目標同約束、設計升級路徑同失效模式,並喺系統失敗時負責後果。

關鍵係抽象化:跳出AI嘅速度同規模,從更高層次去有效治理,促進更佳嘅決策同安全結果。

冇人類就冇責任,冇AI就冇有效治理。人類設計治理流程,AI執行同監控。

科技領袖嘅下一步

對CIO、CTO、CISO同CDO嚟講,呢個係架構層面嘅命令:

1. 設計監督架構。建立一個涵蓋發現、清單、日誌、風險識別及補救、異常檢測、紅隊測試、審計及持續監控嘅集中AI治理層,覆蓋所有AI系統同代理人。

2. 定義自治界限。設定AI自主行動、升級至人類以及系統自動停止嘅明確閾值。

3. 要求可審計嘅可視性同遙測。確保領導層可以完整檢視代理工作流程,擁有防篡改嘅行為日誌、監督行動同AI觸發干預。

4. 投資於AI原生治理工具。傳統IT同GRC工具未必適合代理系統,需具備專門功能支持各種AI應用場景。

5. 提升高管團隊技能。領袖必須理解AI治理目標,包括可觀察性同系統級風險,而唔只係倫理或監管要求。

現實檢視

幻想係人類監督者可以坐喺每個AI系統上方,隨時介入異常情況。現實係AI已經喺一個人類完全追唔上嘅速度同規模運作。

唯一可持續嘅真正治理方法,就係讓AI監控AI,而人類提升層次,定義標準、設計架構、設定界限,並負責後果。

對科技領袖嚟講,真正嘅考驗係你哋有冇建設一個企業級嘅AI監管AI嘅監督體系,夠快、夠透明、夠可審計,值得你哋所部署嘅強大能力。

—— Emre Kazim,Holistic AI聯合創辦人兼聯合CEO,為SiliconANGLE撰文。

—

評論與啟發

文章深刻指出,隨住AI系統運作速度及複雜度急劇提升,傳統依賴人類逐一審查嘅「人類介入監督」已不合時宜,甚至成為治理盲點。這個觀點非常重要,因為香港及全球嘅企業、政府機構都面對如何在AI應用中保持監管有效性嘅挑戰。

從另一角度睇,AI監控AI嘅模式反映咗一個治理哲學嘅轉變:人類不再係直接操控細節,而係透過設計規則、監督監督者(即AI監控系統)嚟實現「軟治理」。呢種「抽象治理」需要高層領導者具備更強嘅系統思維,並且要求建立透明、可審計嘅技術基礎,避免信任危機。

然而,呢個轉變亦帶嚟新嘅風險,例如AI監控系統本身嘅漏洞、偏見或錯誤,可能被忽視或誤判。人類如何確保呢啲監控AI嘅運作公正可靠,仍係未來重點研究方向。

對香港企業嚟講,面對AI技術嘅快速發展,必須加快推動AI治理架構升級,投資AI原生監控工具,並培養具備AI治理能力嘅領導團隊。只有咁,先能在全球AI競爭中保持競爭力,並確保社會對AI應用嘅信任。

總結,AI監控AI唔係放棄人類責任,而係進入一個新嘅治理時代,人類要更智慧、更戰略性地引領AI,確保科技發展造福社會,而非失控。

以上文章由GPT 所翻譯及撰寫。而圖片則由GEMINI根據內容自動生成。