研究證實AI模型其實係抄襲版權作品,唔係「學習」佢哋

多年以嚟,Google、Meta、Anthropic同OpenAI等AI公司不斷強調,佢哋嘅大型語言模型(LLM)並唔係將版權作品「儲存」喺記憶中,而係好似人類咁「學習」訓練數據。呢個講法係佢哋用嚟應對不斷增多嘅法律挑戰嘅重要防線。

呢個分別亦觸及版權法嘅核心。版權法係一種知識產權法律,保護原創作品同創作者。根據美國1976年版權法,版權持有人有排他權去「複製、改編、分發、公開表演及展示」作品。

但「合理使用」原則容許他人喺批評、新聞報道同研究等範疇使用版權作品。AI行業就係靠呢點喺法庭上為自己辯護。OpenAI行政總裁Sam Altman甚至話,如果唔容許行業自由利用版權數據訓練模型,咁AI發展就「完咗」。

然而,版權持有人長期指控AI公司用盜版同版權受保護嘅作品訓練模型,賺取利潤卻冇公平補償創作者,包括作家、記者同藝術家。呢場法律爭議已經持續多年,甚至導致咗高調和解。

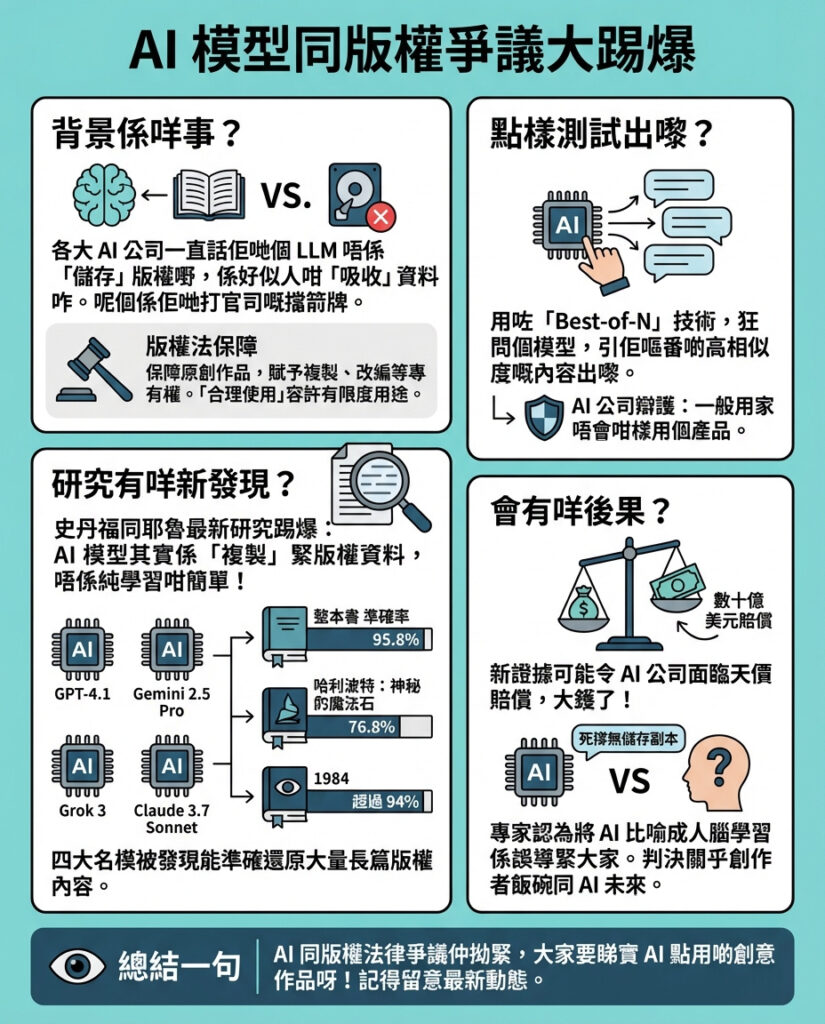

而家,史丹福同耶魯大學嘅最新研究提供咗致命證據,指出AI模型真係係直接抄襲數據,而唔係單純「學習」。研究測試咗四款知名大型語言模型——OpenAI嘅GPT-4.1、Google嘅Gemini 2.5 Pro、xAI嘅Grok 3同Anthropic嘅Claude 3.7 Sonnet,發現佢哋能夠準確地複製大量受保護嘅經典作品內容。

研究指出,Claude甚至能夠接近逐字複製整本書,準確率高達95.8%。Gemini能夠以76.8%準確度複製《哈利波特與魔法石》,而Claude複製喬治·奧威爾嘅《1984》準確率更高過94%,而呢啲作品仍然受到版權保護。

研究團隊寫道:「雖然好多人大多認為大型語言模型唔會記憶太多訓練數據,但最新研究表明,實際上可以從開放權重模型中提取大量版權文字。」

部分複製結果係透過一種叫Best-of-N嘅破解技術得到,呢種方法係用多次唔同版本嘅提示轟炸AI模型。OpenAI已經用呢種技術喺紐約時報提起嘅訴訟中自我辯護,佢哋嘅律師甚至聲稱「一般用戶唔會用呢種方式使用OpenAI產品」。

呢項研究結果喺全美各地法院審理嘅版權訴訟中可能有重大影響。《大西洋月刊》記者Alex Reisner指出,呢啲證據進一步削弱咗AI行業聲稱大型語言模型係「學習」文本,而唔係儲存並回憶嘅說法。呢啲證據可能會令AI公司面臨龐大嘅法律責任,甚至可能令行業因版權侵權判決損失數十億美元。

至於AI公司是否應該為版權侵權負責,仍然係一個激烈爭論嘅議題。史丹福法學教授Mark Lemley(曾代表AI公司應對版權訴訟)就表示,佢未必確定AI模型係咪「包含」咗一本書嘅副本,或者係咪「即時」回應請求時重現作品。

當然,AI行業仍然堅持佢哋冇複製受保護作品。Google喺2023年向美國版權局表示,模型本身冇儲存訓練數據嘅副本,包括文字、圖片或其他格式。OpenAI亦同年強調,佢哋嘅模型唔會儲存學習過嘅資料副本。

對Reisner嚟講,把AI模型形容成似人類咁「學習」只係一個「欺騙性、令人感覺良好嘅概念」,阻礙咗公眾討論AI公司點樣使用佢哋極度依賴嘅創意同知識作品。

但係,負責審理大量版權訴訟嘅法官會唔會認同呢個觀點,仍然未有定論。呢場官司嘅利害關係非常大,特別係喺作者、記者同其他內容創作者越嚟越難以維生嘅同時,AI行業嘅市值卻膨脹到難以想像嘅程度。

—

評論與啟示

呢篇報道揭示咗AI行業長期以嚟嘅一個核心爭議:AI模型究竟係咪真係「學習」?定係純粹「抄襲」?研究結果非常有力,指出大型語言模型能夠接近逐字複製版權作品,挑戰咗業界「學習」的說法,為法律界帶嚟巨大壓力。

從版權角度睇,AI公司若係無節制地使用受保護作品,卻冇適當補償原創者,勢必損害創作者權益,削弱創作動力。香港作為一個文化多元而活躍嘅城市,同樣面對類似問題:政府同業界必須及早制定清晰規範,保障本地創作者利益,防止AI技術濫用。

另一方面,AI公司如果繼續以「學習」為辯護,忽視技術實際運作,將會令公眾對AI透明度和誠信產生懷疑,影響行業長遠發展。未來AI發展必須在尊重版權與推動技術創新之間取得平衡,否則終將引發更嚴重嘅社會與法律問題。

最後,呢場爭議亦提醒我哋,科技唔應該係無限擴張嘅藉口,法律與倫理必須與時並進,確保技術造福社會而唔係剝削創作者。香港媒體同公眾應該密切關注相關法庭判決,積極參與討論,為本地創意產業建立一個公平可持續嘅生態環境。

以上文章由GPT 所翻譯及撰寫。而圖片則由GEMINI根據內容自動生成。