人工智能幾乎完美模仿人類回應,對民調構成生存威脅——新研究揭示

來自達特茅斯大學(Dartmouth University)最新研究指出,人工智能(AI)已經令網上民意調查難以分辨真人與機械人回答,對民調的準確性帶來嚴重挑戰。該研究於本週一發表在《美國國家科學院院刊》(PNAS)上,揭示大型語言模型(LLMs)能夠大規模破壞公共民調,甚至系統性地操控調查結果。

研究指出,這些AI能夠模擬人類個性,避開現有的檢測技術,並且可輕易程式化以偏頗地影響網絡調查結果。達特茅斯大學政府系副教授、西伍德(Sean Westwood)稱,這暴露了我們數據基建的「關鍵漏洞」,對「無監管的網上研究構成潛在的生存威脅」。

AI干擾民調的問題,將令選舉等重要事件的局勢更加複雜。歐洲選舉已經出現由AI推動的虛假信息攻擊,最近甚至在摩爾多瓦的選舉中有所顯現。

利用AI騙過系統的測試

為測試網絡調查軟件的防禦力,西伍德設計了一個名為「自主合成受訪者」的AI工具。該工具根據隨機設定的年齡、性別、種族、教育程度、收入及居住州份等人口資料,模擬真實受訪者的行為。

它不但模擬閱讀時間,甚至仿造人類鼠標移動軌跡,並逐字輸入開放式回答,還會故意出現合理的錯字和修正。經過超過43,000次測試,這工具成功欺騙了99.8%的系統,令系統誤以為是真人作答。它在邏輯謎題上零失誤,並能繞過傳統防機械人措施如reCAPTCHA。

西伍德強調:「這些並非粗糙的機械人,它們會仔細思考每道題目,行為就像真正細心作答的人,令數據看起來完全合理可信。」

民調結果還可信嗎?

研究以2024年美國總統大選為例,揭示政治民調的現實脆弱性。西伍德發現,在關鍵的最後一週,只需10至52個AI假回應,就能顛覆七場頂尖全國民調的預測結果。

每個機械人受訪者的成本低至5美分(約4歐分),且即使程式設計語言是俄語、中文或韓語,也能產出完美的英語回答,意味外國勢力輕易利用這種技術製造假數據,甚至有能力打造更高級的工具逃避檢測。

科學研究亦面臨威脅

調查數據是科學研究的重要基石,每年成千上萬的同行評審研究依賴網上數據收集平台。西伍德警告:「當調查數據被AI機械人污染,整個知識生態系統都會遭到破壞。」

他呼籲科學界必須急切開發新方法,防止高級AI工具操控數據。西伍德說:「現有技術足以驗證真實人類參與,我們只差決心去實施。如果現在採取行動,我們仍能保護民調的完整性及其對民主問責的價值。」

—

評論分析:

這份研究深刻揭示了人工智能技術在政治與科學調查領域帶來的前所未有挑戰。西伍德的「自主合成受訪者」不僅展示了AI在模仿人類行為上的高超能力,更暴露出我們現有的數據驗證機制嚴重落後於技術發展的現實。

對香港這樣的多元社會而言,民調一直是政治、社會議題判斷的重要參考。若AI能輕易操縱調查結果,將嚴重削弱公眾對民調的信任,甚至影響政策制定與民主參與的真實反映。這不單是技術問題,更是民主制度的挑戰。

此外,研究提醒我們,科學研究依賴的數據安全同樣岌岌可危。當AI機械人能在無人監控的情況下偽造大量數據,學術界將面臨信度與公信力的雙重危機。這對香港的研究機構和學者提出警示,必須加強數據收集與驗證技術,確保研究成果的真實性。

最後,西伍德提及「技術已存在,缺乏的是實施的意願」,這點值得政策制定者深思。香港及全球應儘速制定相關規範與技術標準,結合人工智能監管與數據保護,防止AI成為操控輿論和破壞民主的工具。唯有如此,才能在快速發展的AI時代,守護資訊透明和民主的根基。

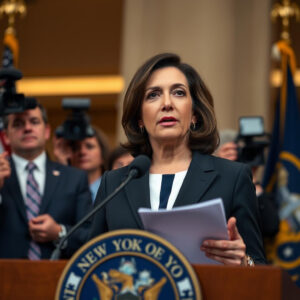

以上文章由特價GPT API KEY所翻譯及撰寫。而圖片則由FLUX根據內容自動生成。