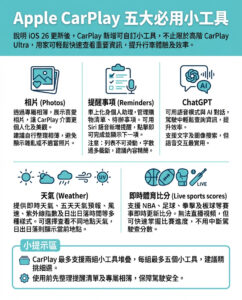

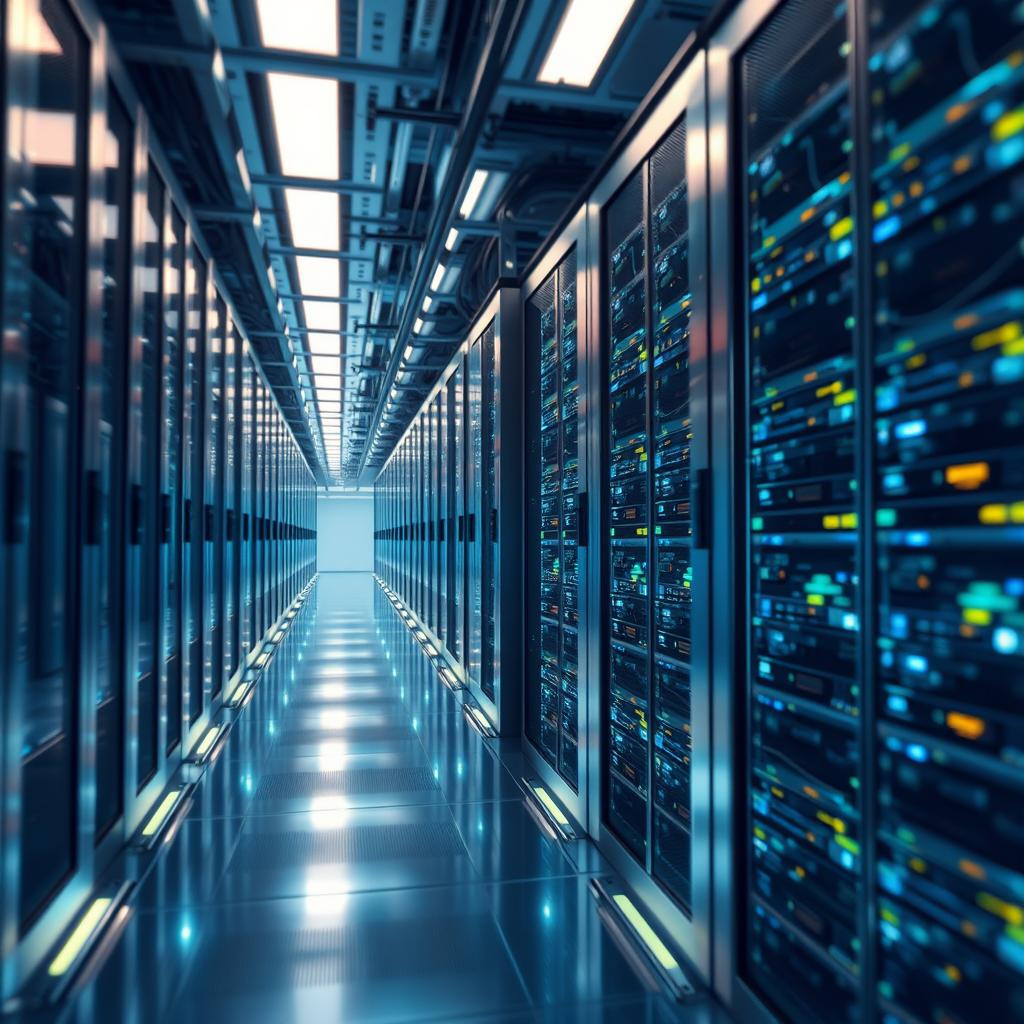

Musk的xAI計劃建設擁有100萬個Nvidia AI加速器的超級電腦

目前運行xAI的Grok語言模型的超級電腦已經擁有超過100,000個GPU,但創辦人Elon Musk希望大幅擴增這個數字。如果他如願以償,xAI的「Colossus」機器將很快擁有100萬個GPU。這一計劃的目的是希望能夠以某種方式提升公司的人工智能技術,但這並不是唯一一個通過增加硬件來改善聊天機器人的企圖。

Colossus是由100,000個Nvidia H100「Hopper」AI加速器組成的。這些卡片基於Nvidia RTX 40系列顯示卡相同的Lovelace微架構,專為高端推理工作負載而設計,擁有更快的數據接口和更大的高速內存配置,使得H100成為世界上最頂尖的AI加速器,直到Nvidia解決Blackwell的熱量問題。

Musk在大約一年前成立了他的AI公司,這比Google和Microsoft等公司早了許多,後者早已開始投入巨資建設AI基礎設施。因此,xAI仍在追趕中。根據《金融時報》的報導,擴建田納西州設施以承載AI運營的工作已經開始。Nvidia、Dell和Supermicro將在該地區設立業務,以專門支持這一項目。

即使在最理想的情況下,為xAI集群增加90萬個H100 GPU的成本也是難以想像的。單個H100的價格約為25,000美元,但如果需要通過第三方獲得這些需求量大的組件,價格可能會更高。因此,這一擴建計劃的硬件成本可能超過200億美元,這還不包括增加的電力消耗或人員配備。不過,對於身價約3000億美元的世界首富來說,這並不是一個無法克服的問題。

像大多數AI巨頭一樣,Musk的公司在運營上假設,增加計算能力和數據量將能持續改善生成式AI。這種看法在大型科技公司中變成了教條——早期的語言模型確實隨著規模增大而變得更好。然而,即使是最強大的大型語言模型(LLMs)仍然存在著舊有的缺陷,包括自信地陳述不實信息的惡習,這被稱為幻覺。

即使xAI推出了整個100萬GPU的陣列,也無法保證Grok會變得更好。AI的現狀應該讓人懷疑,增加計算能力究竟能帶來什麼幫助。我們能否使LLMs更快?更準確?是否有足夠的訓練數據來證明擁有100萬個GPU的合理性?到目前為止,這些問題並沒有減少對生成式AI的投資,估計2024年單年的投資將達到2000億美元。

從雜亂的推斷中出現有用的智慧仍然是一個不切實際的夢想,但與此計劃相關的持續成本卻是非常現實的。AI加速器在狹小的空間內全速運行數月。根據《華爾街日報》的報導,大型科技公司近年來在AI上的支出中大約一半用於更換燒毀的GPU。因此,購買數十萬的顯示卡僅僅是開始。

儘管生成式AI的潛力尚未實現,Musk的公司和業界其他公司一樣,依然資金充裕。xAI的估值約為450億美元,最近又從私人投資者那裡籌集了50億美元的現金。這可能會驗證「更多計算能力能使AI運作」的說法。

—

在這一計劃中,我們可以看到Musk在AI領域的雄心壯志,然而,實際上,僅僅依賴硬件的增加並不一定能解決AI的根本問題。AI的發展不僅僅是關於計算能力,還包括算法的改進和數據質量的提升。現階段,生成式AI面臨著幻覺等問題,這些問題的解決需要更深入的研究和創新,而不是單純的資金投入。因此,Musk的計劃或許會引發行業的更多思考,如何平衡硬件投資與算法創新是未來AI發展的關鍵。

以上文章由特價GPT API KEY所翻譯及撰寫。而圖片則由FLUX根據內容自動生成。