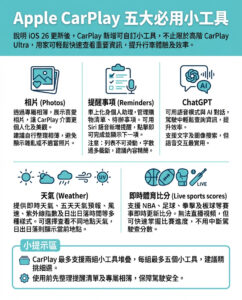

大型語言模型中的幻覺與六種有效預防策略

在大型語言模型(LLMs)中,「幻覺」指的是模型生成的語義或語法上似乎合理,但事實上卻不正確或毫無意義的輸出。例如,當模型錯誤地聲稱艾迪生病會導致「鮮豔的黃色皮膚」,而實際上它會引起疲勞和低血壓時,就會發生幻覺。這一現象在人工智能(AI)領域中引起了廣泛關注,因為它可能導致虛假或誤導性信息的擴散。AI幻覺問題已在多項研究中進行探討,《ACM Computing Surveys》中的一項調查將幻覺描述為「感覺真實的虛幻知覺」。理解和減輕AI系統中的幻覺至關重要,以確保其可靠部署。以下是預防LLMs幻覺的六種方法:

使用高質量數據

使用高質量數據是最簡單的措施之一。訓練LLM的數據作為其主要知識基礎,任何數據集的不足都可能直接導致錯誤的輸出。例如,在教授模型提供醫療建議時,如果數據集對於罕見疾病的覆蓋不全面,則可能導致模型在這些問題上生成錯誤或不完整的回應。通過使用範圍廣泛且細節準確的數據集,開發者可以最大程度地減少與缺失或錯誤數據相關的風險。結構化數據在這一過程中至關重要,因為它為AI提供了一個清晰且有組織的學習框架,與混亂或非結構化數據相比,後者可能導致歧義。

使用數據模板

在數據質量的基礎上,實施數據模板提供了另一層控制和精確性。數據模板是預定義的結構,指定了特定任務的預期格式和允許的響應範圍。例如,在財務報告中,模板可能會定義資產負債表所需的字段,如資產、負債和淨收入。這種方法確保模型遵循特定領域的要求,並有助於保持輸出的一致性。模板通過嚴格遵循預定的指導方針,防止生成不相關或不準確的回應。

參數調整

另外一種有效減少幻覺的方法是參數調整。通過調整關鍵推理參數,開發者可以微調LLM的行為,使其更好地與特定任務對齊。參數如溫度、頻率和存在懲罰允許對模型輸出特徵進行細緻控制。在詩歌或講故事等創意應用中,可能會使用較高的溫度設置來引入隨機性和創造力。相反,對於技術或事實輸出,使用較低的溫度可以確保準確性和一致性。微調這些參數使模型能夠在創造力和可靠性之間取得適當的平衡。

實踐提示工程

提示工程也是減輕幻覺的有價值工具。這種方法涉及精心設計提示,指導模型生成相關輸出。通過提供清晰的指示和示例問題,並為AI分配特定角色,開發者可以提高其回應的質量。例如,在詢問模型有關通脹對利率的經濟影響時,提示「作為金融專家,解釋通脹如何影響利率」為所需的回應類型設置了明確的期望。

檢索增強生成(RAG)

RAG代表了一種更先進的技術,用於確保LLM輸出的準確性。RAG將AI模型的生成能力與外部知識源(如數據庫或策劃文檔)結合起來。這一整合使模型能夠基於事實、特定領域的信息來支持其回應,而不僅僅依賴其訓練數據。例如,配備RAG的客戶支持聊天機器人可以參考產品手冊,精確回答用戶查詢。通過納入外部知識,RAG減少了訓練數據偏見的影響,確保模型的輸出準確且與上下文相關。

人工事實檢查

人工監督仍然是防止LLMs幻覺的不可或缺的一部分。人工事實檢查員在審查AI生成內容方面扮演著關鍵角色,以識別和糾正模型可能忽略的不準確之處。在高風險場景中,如新聞生成或法律文件起草,這一檢查層面至關重要,因為事實錯誤可能會產生重大後果。例如,在新聞生成系統中,人類編輯可以在發佈前核實AI所呈現的事實,從而防止虛假信息的傳播。此外,人工審核者提供的反饋可以用於改善模型的訓練數據,進一步提高其準確性。

因此,減少LLMs幻覺的好處包括:

– 最小化幻覺確保AI系統生成用戶可以信賴的輸出,增強在醫療和法律等關鍵應用中的可靠性。

– 準確且一致的輸出增強用戶的信心,促進AI技術的更廣泛採用。

– 減少幻覺防止金融或醫療等領域的錯誤信息,使專業人士能夠根據準確的AI生成見解做出明智的決策。

– 減少幻覺使AI系統符合道德準則,防止虛假或誤導性信息的傳播。

– 準確的AI回應減少對人工審查和修正的需求,從而節省操作流程中的時間和資源。

– 解決幻覺問題改善訓練數據和模型開發,促進AI研究和技術的進步。

– 可信的AI系統可以在更敏感、高風險的環境中部署,因為準確性是不可妥協的。

總結來說,這六種策略針對幻覺問題的具體方面,提供了一個全面的框架來減輕風險。高質量數據確保模型有可靠的基礎,而數據模板則提供了一個結構化的指導,以實現一致的輸出。參數調整允許根據不同應用定制回應,而提示工程則增強了查詢的清晰度和相關性。RAG通過整合外部知識源引入了額外的事實基礎,而人工監督則作為防止錯誤的最終保障。

在這個快速發展的AI時代,如何有效地減少幻覺問題是確保人工智能技術安全可靠的關鍵之一。隨著這些方法的應用,未來的AI系統將能夠更好地服務於人類社會,並在各個領域發揮更大的價值。

以上文章由特價GPT API KEY所翻譯及撰寫。而圖片則由FLUX根據內容自動生成。