深度偽造技術如何可能引發末日危機

美國核武警報系統未能準備迎接人工智能挑戰

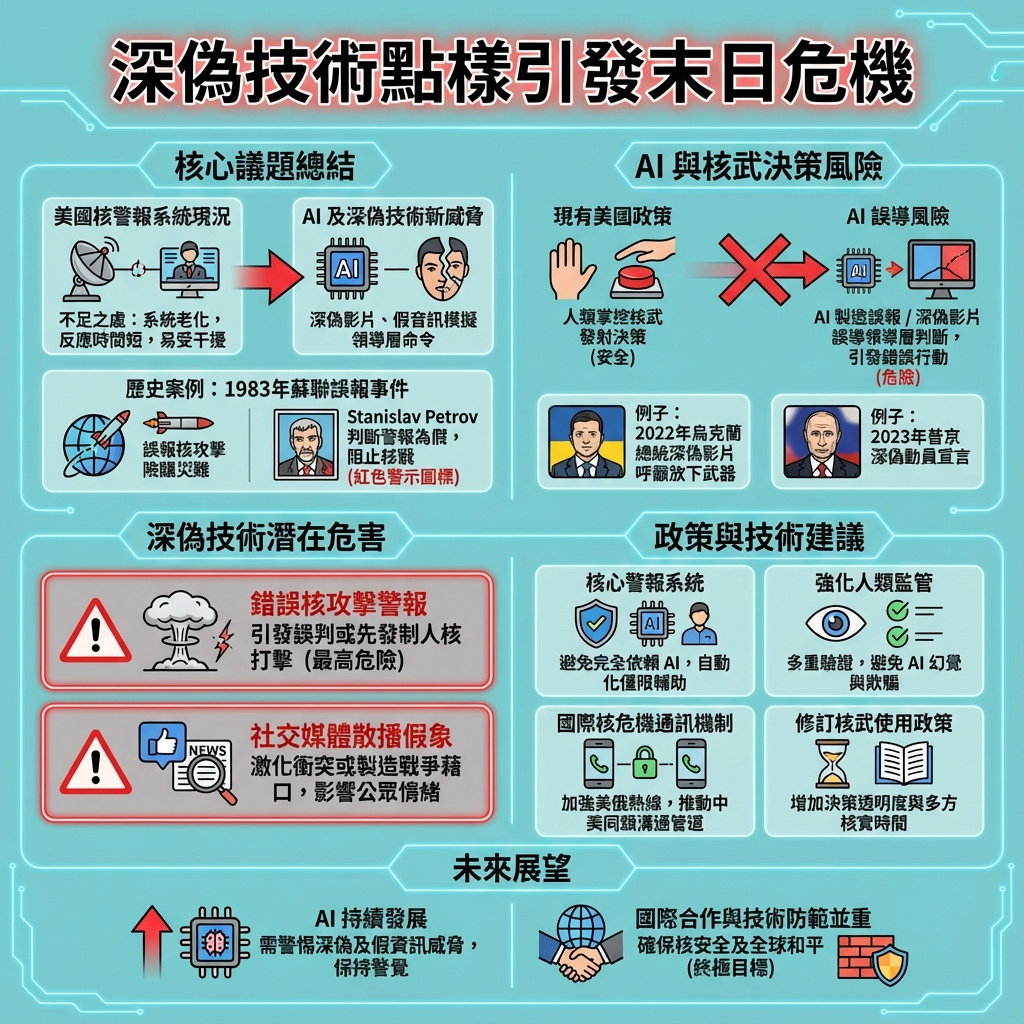

自核武時代開始以來,政策制定者和戰略家一直努力防止國家誤用核武器,但事故風險依然高企,甚至與冷戰時期無異。1983年,蘇聯的早期警報系統錯誤判斷美國對蘇聯發動核打擊,這種警報本可觸發蘇聯的毀滅性反擊。幸運的是,當時值班主管斯坦尼斯拉夫·彼得羅夫判斷警報是誤報,才避免了災難。若非如此,蘇聯領導層可能會對美國發動毀滅性核攻擊。

隨著人工智能的迅速普及,核穩定面臨的威脅亦日益加劇。其中一大憂慮是,核武國家或會將是否使用核武的決定權交由機器決定。不過,美國已設置保障措施,確保人類仍掌握最終核打擊決策權。根據2022年《國防戰略》,人類將繼續「介入」核武使用或停止使用的決策過程。美國總統拜登與中國國家主席習近平亦在聯合聲明中同意,核武使用決策必須由人類控制。

然而,人工智能帶來另一種隱藏的核安全風險——深度偽造技術。深度偽造是指通過人工智能技術,製作出極具說服力的偽造影片、圖片或聲音,用以散播虛假信息。這些技術越趨先進。2022年俄羅斯入侵烏克蘭後不久,網上流傳一段烏克蘭總統澤連斯基呼籲國民放下武器的深度偽造影片;2023年,又有深度偽造影片令民眾誤以為俄羅斯總統普京中斷國家電視宣布全面動員。更極端的情況下,深度偽造可能令核武國家領導誤判敵人已發動先發制人攻擊,或人工智能支持的情報平台錯誤發出敵方動員、甚至「骯髒炸彈」襲擊警報。

特朗普政府希望積極利用人工智能強化國家安全。今年七月發布的行動計劃呼籲在國防部積極推動人工智能應用,十二月推出了GenAI.mil平台,為員工提供人工智能工具。但在將AI融入國家安全基礎設施時,政策制定者和系統設計者必須謹慎考慮機器在核決策初期的角色。直到工程師能有效解決AI固有的問題,如「幻覺」和欺騙(大型語言模型預測錯誤模式或事實),美國政府必須確保人類仍掌控核早期警報系統,其他核武國家亦應效法。

連鎖危機的可能性

現今特朗普總統透過手機接觸深度偽造影片,並有時在社交媒體轉發,許多親信顧問亦然。真實與虛假信息界線模糊,深度偽造越來越可能影響涉及核武的重大國安決策。

若錯誤信息短暫欺騙美國總統,後果可能是全球災難。根據美國法律,總統下令使用核武毋須與他人協商,無論是反擊還是先發制人。美軍隨時準備部署搭載核彈頭的飛機、潛艇及地面導彈。美國洲際彈道導彈可在半小時內命中目標,一旦發射,無法召回。

深度偽造可能成為發動戰爭的藉口。美俄核力量均準備「警報即發射」,即敵方導彈一旦被偵測,便可立即反擊,領導人只有數分鐘判斷對方是否已攻擊。(現行美國政策允許總統延遲決定,直到敵方核武打擊到達後。)若美國早期警報系統發現威脅,美方將嘗試利用機密及非機密情報核實,包括衛星影像、外國領袖言論、社交媒體及外國新聞。軍方、官員及政治任命者須判斷如何向上級報告及呈現信息。

使用人工智能解讀早期警報數據或引發連鎖危機。AI可能「幻覺」出不存在的攻擊,令美國官員陷入四十年前彼得羅夫的抉擇困境。由於AI系統內部邏輯不透明,人類往往不明白AI的判斷依據。研究顯示,對AI有一般認知的人常傾向相信機器輸出,而非檢查偏誤或誤報,尤其是在國安領域。若缺乏充足訓練和工具,白宮決策顧問可能會默認或至少考慮AI生成內容為真。

公開媒體傳播的深度偽造同樣危險。美國領導人看過一段深度偽造影片後,或會誤判俄羅斯導彈試射為攻擊開始,或誤將中國實彈演習視為襲擊美國盟友。深度偽造可成為戰爭藉口,煽動民眾支持衝突,或播下混亂種子。

審慎的目光

七月,特朗普政府發布AI行動計劃,呼籲在全球最大官僚機構——國防部內積極推動AI工具。AI確實提升軍事效率,例如機器學習助理海軍驅逐艦維護排程,自主武器如無人機令士兵遠離前線,AI翻譯工具助情報人員解析外國數據,甚至有助辨識空軍基地轟炸機照片的細微變化。

但推行AI不應全有或全無。某些範疇應禁止AI介入,如核早期警報系統及指揮控制系統,因幻覺和欺騙風險超越AI帶來的效益。最佳AI系統需建立在交叉驗證及全面數據集上,但核早期警報系統缺乏這些,因自廣島長崎以來未有核攻擊。任何AI核偵測系統或需訓練於現有導彈試射、太空追蹤數據及合成數據,並須設計防止幻覺及錯誤置信度評估,技術挑戰極大。

雖然用AI取代高訓練人員的檢查或用AI融合多數據以加快分析有誘惑,但移除關鍵人類審視易引發錯誤、偏見和誤解。國防部要求自主無人機須有意義的人類控制,核早期警報及情報技術亦應達更高標準。AI數據整合工具不應取代報告來襲彈道導彈的人類操作員。衛星或雷達數據確認核發射警報應保持部分自動化。重要國安會議應只考慮經核實且未被篡改的數據。

2025年7月,國防部向國會申請經費,以將新技術納入核指揮控制通訊系統。美國政府應將AI和自動化限制於網絡安全、商業流程分析和簡單任務,如確保備用電源啟動。

傳統策略的當代意義

現今核戰風險為數十年來最高。俄羅斯在烏克蘭威脅使用核武,中國迅速擴張核武庫,北韓具備射程覆蓋美國的洲際彈道導彈,防止核擴散政策動搖。在此背景下,確保人類而非基於不完整或錯誤數據訓練的機器判斷敵方意圖尤為重要。

情報機構須提升追蹤AI生成信息來源的能力,並標準化向政策制定者傳遞增強或合成數據的方式。例如,美國國家地理空間情報局使用AI生成情報時,會在報告中標明內容為機器生成。情報分析員、政策制定者及其團隊應加強懷疑態度和事實核查,如同企業防範網絡釣魚般。情報機構亦需贏得政策制定者信任,因他們可能更信任眼見為實或設備顯示的信息,而非情報評估。

專家和技術人員應持續尋求標記及減緩社交媒體中虛假信息、圖片和影片流傳的方法,以免影響政策制定。鑑於開放信息難以管控,機密信息的準確性更為關鍵。

特朗普政府在《國防戰略》中更新美國核姿態,理應防範AI帶來的核武信息風險,重申核發射決策必須有人類控制。首先,所有核武國家應同意核使用決策僅由人類作出,並改善危機溝通渠道。華盛頓與莫斯科已有專線,卻無華盛頓與北京的直通熱線。

美國核政策自1980年代以來變化不大,當時領導人擔心蘇聯突然攻擊,但無法預見今日決策者私人設備充斥錯誤信息。立法與行政部門應重新評估冷戰時代的核武政策,或許可要求未來總統在發動先發制人核打擊前與國會領袖協商,或設置情報專業人士核實決策依據的時間。美國具備強大二次打擊能力,準確比速度更重要。

人工智能已具有欺騙核決策者及指揮鏈成員,使其誤判不存在攻擊的潛力。過去唯有真誠對話與外交避免核武國家誤解,未來政策與實踐必須防範這種隱伏的資訊風險,免致世界末日。

—

評論與啟示

這篇文章深刻揭示了人工智能,尤其是深度偽造技術,對核安全帶來的前所未有挑戰。過去核戰風險主要來自技術故障或人為誤判,但現在,虛假的視聽信息可直接操作決策者的感知,極大提升誤判的可能性。這不僅是技術問題,更是政治與心理層面的危機。

令人警醒的是,現行核決策授權過於集中,總統可單獨下令核打擊。面對AI驅動的虛假信息,這種權力結構顯得格外脆弱。文章建議引入更多制度制衡,如要求與國會協商,或設置核決策前的核實期,這些都是值得嚴肅考慮的改革方向。

此外,文章指出AI的「幻覺」現象及不透明判斷過程,提醒我們不能過度依賴AI輔助,尤其在核早期警報系統中。這說明未來的技術發展必須兼顧可解釋性與透明度,才能贏得人類決策者信任。

最後,跨國危機溝通機制的缺失也暴露出全球核安全的薄弱環節。建立更多直接溝通管道,尤其是美中之間的熱線,將有助於減少誤判。

總結來說,這篇報道不僅是對核安全技術層面的警示,更是對全球政治架構和決策機制的深刻反思。面對AI時代的資訊威脅,國際社會必須更新冷戰思維,重新制定核政策,確保人類智慧與技術力量能共存,避免一場由虛假信息引發的真實災難。

以上文章由特價GPT API KEY所翻譯及撰寫。而圖片則由FLUX根據內容自動生成。