影子AI:企業難以控制未經授權的新工具使用

作者:保羅·基林

Katie Smith在一家跨國零售連鎖店工作了六年,負責數據分析和財務,但該公司因為擔心員工的線上活動而封鎖了所有生成性人工智能網站,並限制了YouTube的使用。因此,Smith決定自行其事。她使用個人的ChatGPT帳戶來協助撰寫工作郵件,並利用Grammarly Inc.的英語寫作助手進行調整,還借助Canva Inc.的圖形設計平台的AI功能來製作演示文稿。她表示:「零售業從來不是技術創新的先驅。」

上個月初,Smith更換了工作,成為一家大型諮詢公司的數據和AI策略經理(她要求不透露公司名稱)。這段經歷簡直是天壤之別。

Smith說:「他們所允許的事情太令人驚訝了。我們非常支持AI,給予員工訪問助手和AI生態系統中許多其他能力的權限。」

Smith的經歷展現了「影子AI」的現象,即員工在沒有IT部門批准或知情的情況下使用AI工具。據多方報導,生成性AI在大多數組織中已經被廣泛使用,無論其是否獲得許可。

Prompt Security Inc.最近的一項調查發現,組織平均使用67種AI工具,其中90%的工具未獲得IT部門批准。Cap Gemini S.A.報告指出,超過60%的軟件開發人員在使用生成性AI時並未獲得正式授權。

這種現象並不新鮮。自1980年代個人電腦問世以來,人們一直在以「影子IT」的形式從後門引入技術。局域網、電子郵件、互聯網、軟件即服務和智能手機等技術在IT組織制定政策之前就已經被廣泛使用。

不過,AI有其不同之處。與主要處理和存儲數據的生產力軟件和互聯網不同,AI模型可以將用戶提供的信息納入其訓練數據中。這增加了意外數據泄露、隱私風險和安全漏洞的風險。使用AI改善代碼質量的軟件開發人員可能無意中將公司的知識產權輸入到訓練模型中,這正是兩年前三星電子所發生的情況。

人們與AI的互動方式也與傳統IT服務不同。生成性AI的人性化特質更容易吸引用戶建立關係或影響其行為。與傳統軟件相比,生成性AI工具在面對相同輸入時可能產生不同的創意結果、錯誤或幻覺。

Appfire Technologies LLC的首席信息安全官Doug Kersten表示:「如果它不知道答案,它可能會對你撒謊或者編造內容。過去的影子IT是有人在Excel上做會計,你卻不知道。現在,AI則涉及法律、治理和監管問題。」

對於企業來說,現在越來越意識到需要設置防範措施。國際隱私專業人士協會的AI治理培訓計劃已有約12,000人參加,該協會的AI治理中心的執行董事Ashley Casovan表示:「這是迄今為止最大的AI治理計劃採用。」

不透明的政策

生成性AI的出現速度之快,使得許多組織無法制定或執行明確的使用政策。Unily Group Ltd.最近的一項調查發現,只有14%的員工認為其組織的AI使用政策「非常清晰」,39%的人表示他們容易使用未經批准的工具。每五人中就有一人表示,他們肯定或可能已經在未經授權的AI工具中輸入了敏感信息。

IT組織在監管AI使用方面面臨困境。雖然像OpenAI LLC的ChatGPT和Anthropic PBC的Claude等基於網絡的服務易於監控和封鎖,但現在大多數生成性AI模型已嵌入商業軟件中,成為助手或合作夥伴。WitnessAI Inc.是一家開發企業AI使用監管軟件的公司,已編制了約3,000種此類應用的數據庫。根據一些估計,這個數字可能高達12,000,並且每個月都會增加數百種。

Kersten表示:「它們擴展和增強的速度如此之快,即使你認為已經控制住了,卻發現並非如此。」

商業大型語言模型的主要開發商隨著時間的推移,對其訓練和數據收集實踐變得更加透明,大多數承諾不會將用戶提供的數據納入其訓練模型中。Reality Defender Inc.的聯合創始人兼首席技術官Ali Shahriyari表示:「我認為我們可以信任主流的那些。」

誰擁有數據?

但這些公司並不安全於數據泄露,其對用戶提供數據的保留政策往往不明,即使它們不將其用於訓練模型。Shahriyari表示:「他們可能不會用這些數據進行訓練,但他們仍然擁有這些數據。誰知道他們是否在保存這些數據?」

更大的擔憂是出現的數百家小型公司,它們提供基於生成性AI的服務,這些服務包括生成視頻、協助市場營銷活動、生成簡歷和自動化其他專業任務。這些公司的數據使用政策可能不明,或者用戶根本不去閱讀。

Stratascale的首席信息安全官Casey Corcoran表示:「如果你沒有為服務付費,那麼你可能就是服務的產品。」

必要的工具

企業正在採取各種措施,從完全禁止AI的使用到提供培訓計劃,希望員工能做出良好的決策。Morey Haber,BeyondTrust Corp.的首席安全顧問表示:「至少,組織需要從明確的可接受使用政策開始,將其納入員工手冊,並由員工和承包商簽署。接下來,IT部門需要為監控和使用AI在公司系統上建立技術控制,包括封鎖AI域名和內容,並允許批准的網站。」

許多公司在生成性AI的早期就完全禁止使用ChatGPT,而某些公司,特別是政府機構和受監管行業的公司,至今仍然這樣做。然而,以往的影子IT經驗表明,拒絕員工使用能提高生產力的技術可能會適得其反。

Promevo LLC的數字轉型總監Colin McCarthy表示:「封鎖所有東西會導致用戶反抗。」

Unily的調查發現,54%的企業知識工作者表示,如果管理層取消他們認為是必要的軟件工具,他們會離開工作。Smith表示:「你會失去人才。他們要麼會使用影子AI,要麼會去別的地方。」

在受過高等教育和技術精通的員工中,更常見的做法是SAS Institute Inc.所採用的。這家軟件分析公司在2021年建立了數據倫理實踐,並設有一個監管委員會來管理政策。

該公司維持一個批准工具的清單,並承諾迅速處理員工的新增請求。SAS封鎖了一些生成性AI服務,尤其是DeepSeek,但鼓勵實驗。

首席信息官Jay Upchurch表示:「我們不想成為封鎖的企業。我們試圖在不減慢他們速度的情況下引導人們。我的想法是用善意來解決問題。」

SAS在採用新工具方面採取了嚴謹的方法。當微軟的Copilot首次推出時,IT組織招募了300名志願者來測試和反饋他們與數字助手的使用經驗。報告顯示,每周的平均生產力提高了約40分鐘。

Upchurch表示:「這引起了病毒式的興趣。我們獲得了很多成功和需求,因此在最初幾個月內用戶數量增加到了600人。」

Reality Defender同樣信任其員工遵循準則,並對不符合標準的工具採取「零容忍政策」。Shahriyari表示:「到目前為止,我們不需要採取任何激烈的行動,因為我們的團隊在使用AI工具時都遵循既定參數。」

Appfire在生成性AI的早期設立了一個指導委員會,因為Kersten表示:「如果你不這樣做,你會立即看到每個人以不同的方式使用AI,並試圖將其納入產品中,產生法律責任。」

該公司封鎖了一些被認為風險較高的網站,並為內部使用購買了企業版ChatGPT的許可。Kersten表示:「否則,我們在政策上依賴很多,並告知如果想購買任何與AI相關的東西,需要經過一個批准流程。」

工具的幫助

初創公司和協會正在填補這一空白。IAPP運行AI治理認證計劃,並將於5月和9月舉辦相關會議。

WitnessAI的首席技術官Gil Spencer表示,大多數首席信息安全官對封鎖AI應用並不感興趣,而是想了解它們的使用情況。「當我們開始時,我們認為人們擔心AI攻擊。結果我們發現,CISO們最感興趣的只是知道用戶在做什麼。」

最終,影子AI可能會走上以往影子技術的相同道路。根據Gartner Inc.的預測,到2026年,80%的獨立軟件供應商將在其企業應用中嵌入生成性AI能力,現在關閉這道大門已經為時已晚。

SonicWall Inc.的威脅研究執行董事Douglas McKee表示:「影子AI的初始風險是真實的,但其價值最終將超過這些風險,導致結構化的採用,而非拒絕。」

Smith同意這一觀點。「那些明白AI影響力的人已經自我教育了,」她說,指的是零售連鎖店的同事。「他們會使用它,因為他們希望更高效。」

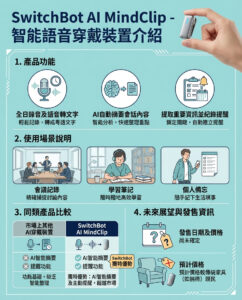

以上文章由特價GPT API KEY所翻譯及撰寫。而圖片則由FLUX根據內容自動生成。